Haben Sie jemals daran gedacht, dass Google Sheets das Web Scraping für Sie übernehmen kann? Tatsächlich kann Google Tabellen als leistungsstarkes Cloud-Tool Daten von Websites extrahieren. Mit leistungsstarken Funktionen wie IMPORTXML und IMPORTHTML können Benutzer Daten direkt von Websites extrahieren und so die Datenerfassung und -analyse vereinfachen. Die extrahierten Daten können Sie direkt mit Ihrem Team oder Freunden teilen oder in andere Tools von Drittanbietern integrieren.

In diesem Handbuch führen wir Sie durch der einfache Prozess des Web Scraping mit Google Sheets und zeigen Ihnen, wie Sie diese leistungsstarken Funktionen zum Sammeln von Daten von verschiedenen Websites verwenden.

Ist Web-Scraping von Google erlaubt?

Das Scrapen von Google-Suchergebnissen ist erlaubt, da sie als öffentlich zugängliche Daten gelten. Es gibt jedoch bestimmte Arten von Daten, wie persönliche Informationen oder urheberrechtlich geschützte Inhalte, die nicht gescraped werden dürfen. Es ist ratsam, vorher rechtlichen Rat einzuholen, um sicherzustellen, dass das Scrapen im Einklang mit den geltenden Gesetzen steht. Es ist auch wichtig, die Nutzungsbedingungen von Google zu beachten, da das Scrapen gegen diese Bedingungen verstoßen kann. Es ist ratsam, Tools und Software zu verwenden, die speziell für das Scrapen entwickelt wurden und sicherstellen, dass keine rechtlichen Grenzen überschritten werden. Letztendlich ist es wichtig, ethisch und verantwortungsbewusst zu handeln und die Privatsphäre und Rechte anderer zu respektieren.

5 Methoden von Google Sheets für Web Scraping

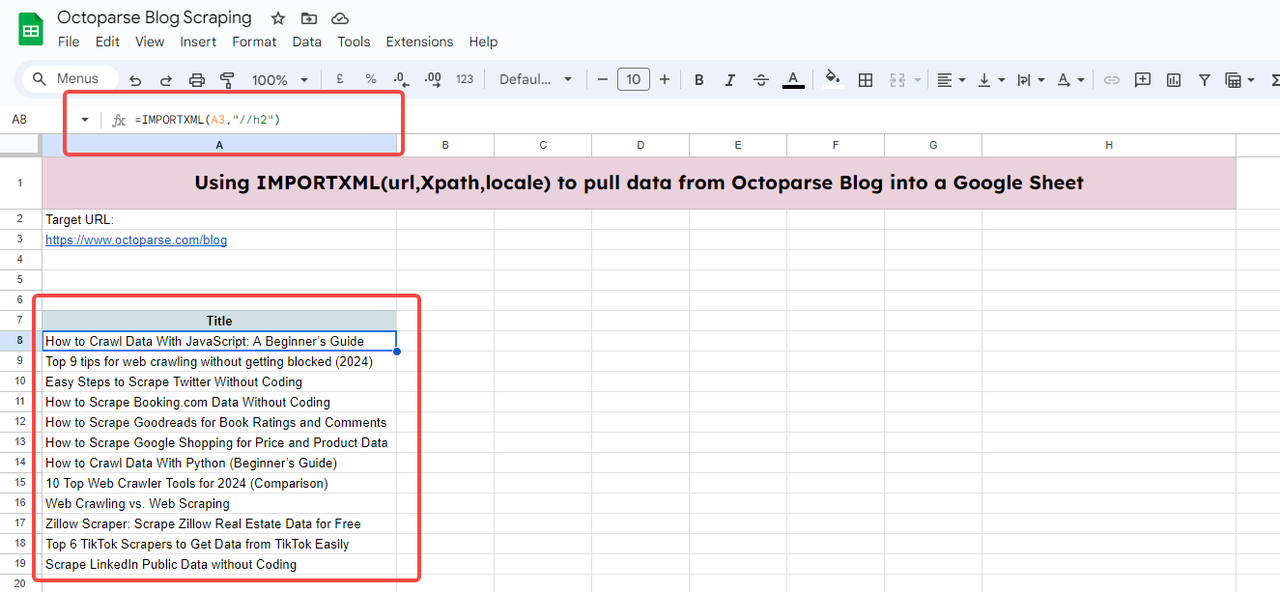

Methode 1: Verwenden von ImportXML in Google Spreadsheets

ImportXML ist eine Funktion in Google Spreadsheets, mit der Sie mithilfe von XPath-Abfragen Daten aus strukturierten Quellen wie XML, HTML, CSV, TSV und RSS-Feeds importieren können.

So sieht es aus:

- URL: Die URL der Webseite.

- xpath_query: Eine XPath-Abfrage zum Auswählen der gewünschten Daten.

- Gebietsschema: Ein Sprach- und Regionscode, der beim Parsen der Daten verwendet werden soll. Wenn nichts angegeben ist, wird das Gebietsschema des Dokuments verwendet.

Im Folgenden zeige ich Ihnen ein Beispiel. Dazu müssen Sie zunächst eine neue Tabelle erstellen oder eine vorhandene öffnen. Klicken Sie dann auf die Zelle, in der die importierten Daten angezeigt werden sollen, und geben Sie die URL und den XPath des zu extrahierenden Elements ein.

Sie müssen den XPath der Artikeltitel abrufen, indem Sie das Zielelement auf der Website prüfen (Rechtsklick, und Sie sehen „Prüfen“).

Hier,

- URL: https://www.octoparse.com/blog

- XPath-Abfrage : //h2

//h2 bedeutet den genauen XPath aller Blogtitel auf Seite eins des Octoparse-Blogs.

Die vollständige Funktion wäre also:

Geben Sie die Funktion in die Zelle ein, in der die importierten Daten angezeigt werden sollen. Möglicherweise müssen Sie auch auf „Datenzugriff“ klicken, damit Google Tabellen externe Daten importieren kann.

Nach einigen Sekunden Ladezeit werden Ihnen alle Titel der ersten Blogseite angezeigt.

1. Sie können die URL auch durch eine Zelle ersetzen, solange Sie die URL in die Zelle einfügen. Siehe hierzu A3.2. Denken Sie daran, Anführungszeichen zu setzen, wenn Sie den XPath und die URL einfügen. Wenn Sie sie durch Zelleninhalt ersetzen, sind keine Anführungszeichen erforderlich.3. Wenn bereits Anführungszeichen vorhanden sind, müssen diese innerhalb des XPath einzeln stehen. Beispiel: „//div[@class=’author’]/span“. Eine falsche Schreibweise wie „//div[@class=”author”]/span” führt zu einem Fehler.4. Sie können das „Gebietsschema“ ignorieren, wenn Sie das Dokumentgebietsschema verwenden möchten.Wenn Sie mit XPath nicht vertraut sind, finden Sie den XPath-Spickzettel.

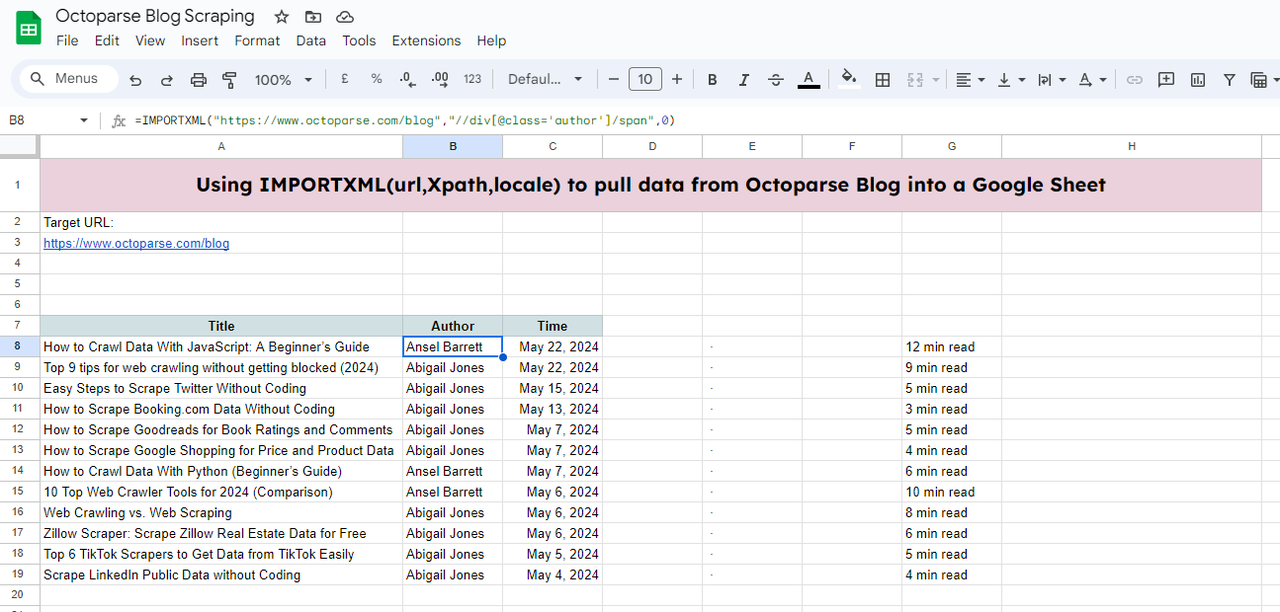

Sie können das Blatt mit weiteren Daten füllen, indem Sie die oben beschriebenen Schritte ausführen.

Beispiel für ein Google-Tabellenblatt: https://docs.google.com/spreadsheets/d/18Tkp6rP9p1Az_AlXyOJlrqVxwESpTDOf7MSIweZnOD0/edit#gid=0

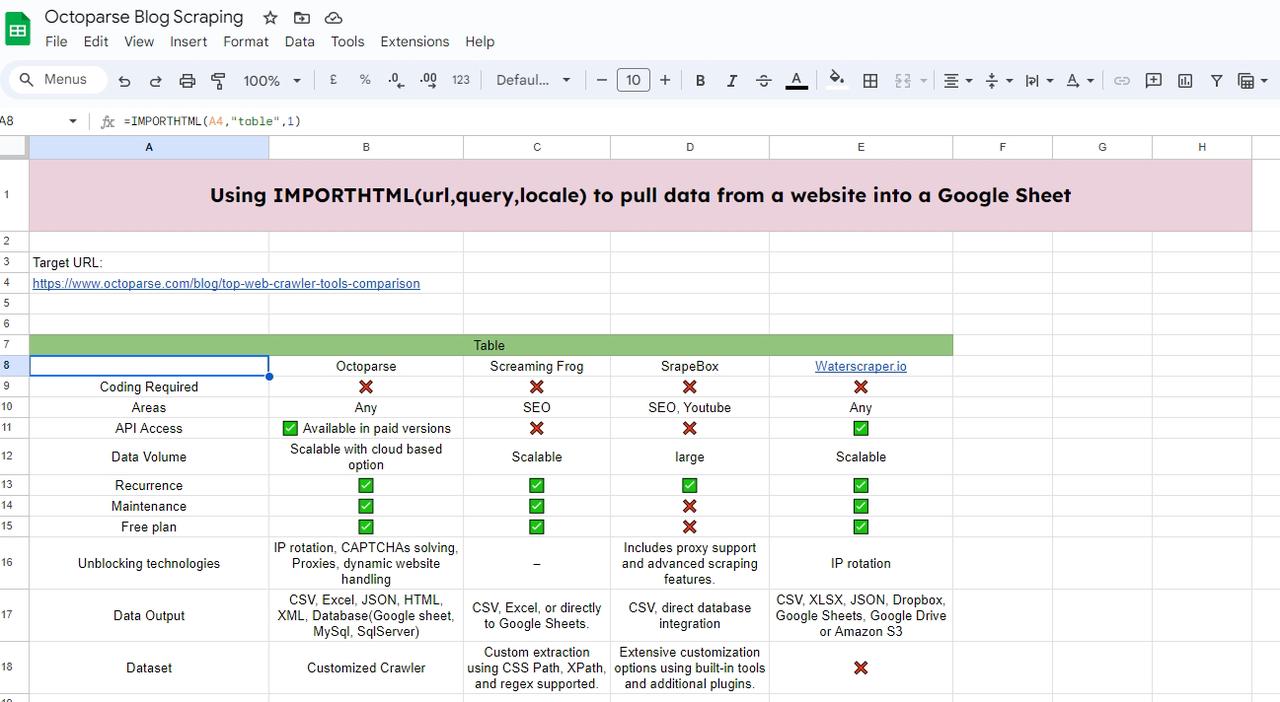

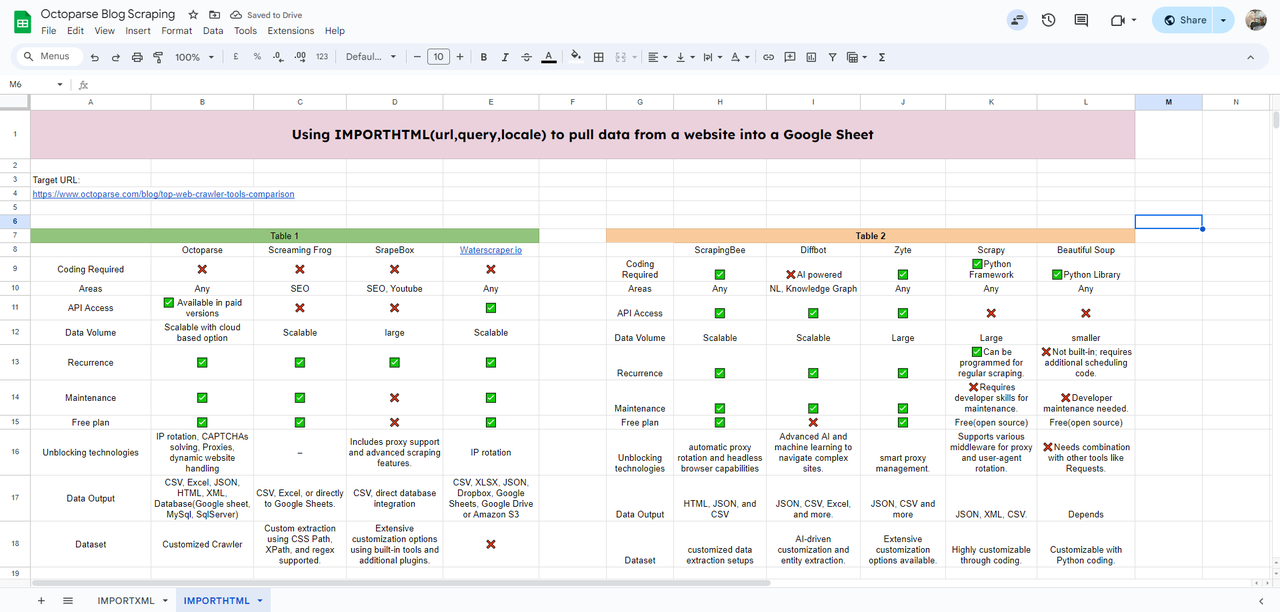

Methode 2: Verwenden von ImportHTML in Google Spreadsheets

Die IMPORTHTML- Funktion in Google Tabellen dient zum Abrufen von Daten aus Tabellen und Listen innerhalb von HTML-Seiten. Um sie zu verwenden, benötigen Sie die URL der Zielwebsite und die Abfrage, die entweder „Tabelle“ oder „Liste“ lautet.

Die Funktion würde folgendermaßen aussehen:

- url: Die URL der Webseite, die die Daten enthält.

- Abfrage: „Tabelle“ oder „Liste“, je nachdem, was Sie extrahieren möchten.

- Index: Die Position der Tabelle oder Liste auf der Webseite (beginnend bei 1).

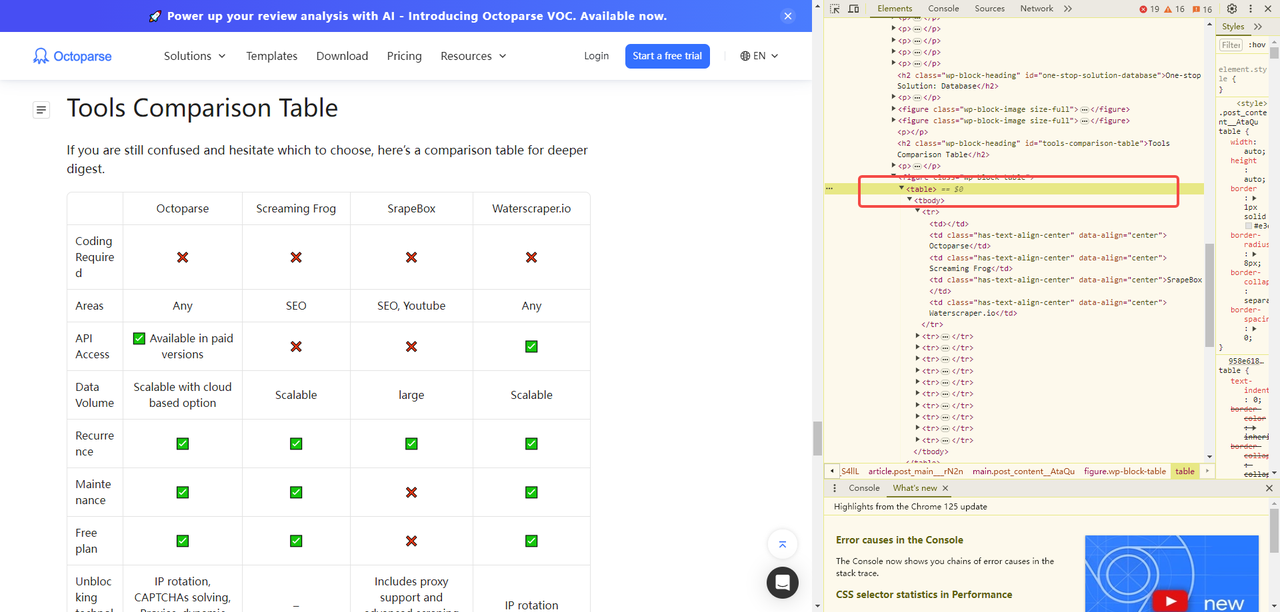

In diesem Beispiel werde ich eine Tabelle aus einem der Blogs von Octoparse extrahieren.

Erstellen Sie zunächst ein neues Blatt und öffnen Sie dann die Ziel-URL.

Hier können Sie im HTML sehen, dass unsere Zieltabelle mit <table> beschriftet ist. Wenn Sie eine Liste scrapen möchten, lautet die Beschriftung <list>.

Um die Tabelle aus dem Blog zu extrahieren, müssen wir die Funktion IMPORTHTML in die Zelle eingeben, in der die importierten Daten erscheinen sollen.

Eingeben:

Dann wird die Tabelle geladen.

Sie können mit dem Scraping fortfahren, indem Sie den Tabellenindex auf 2 ändern, sodass Sie die zweite Tabelle im Blog erhalten.

Tipps:1. Sie müssen der Abfrage doppelte Anführungszeichen hinzufügen.2. Sie können die URL durch eine Zelle ersetzen, in der die URL eingetragen ist.

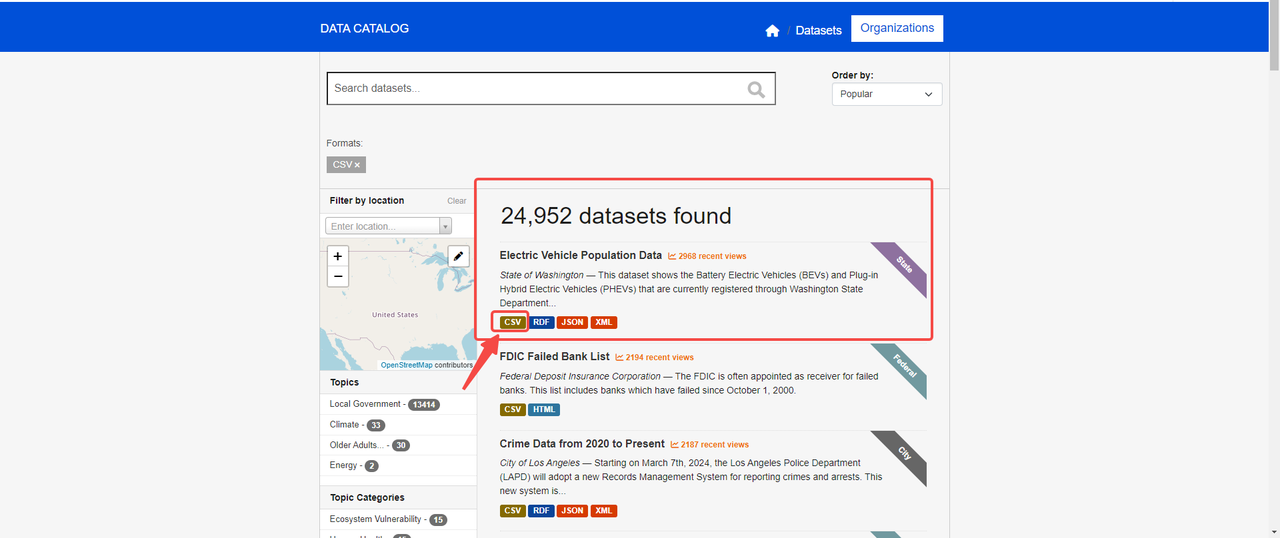

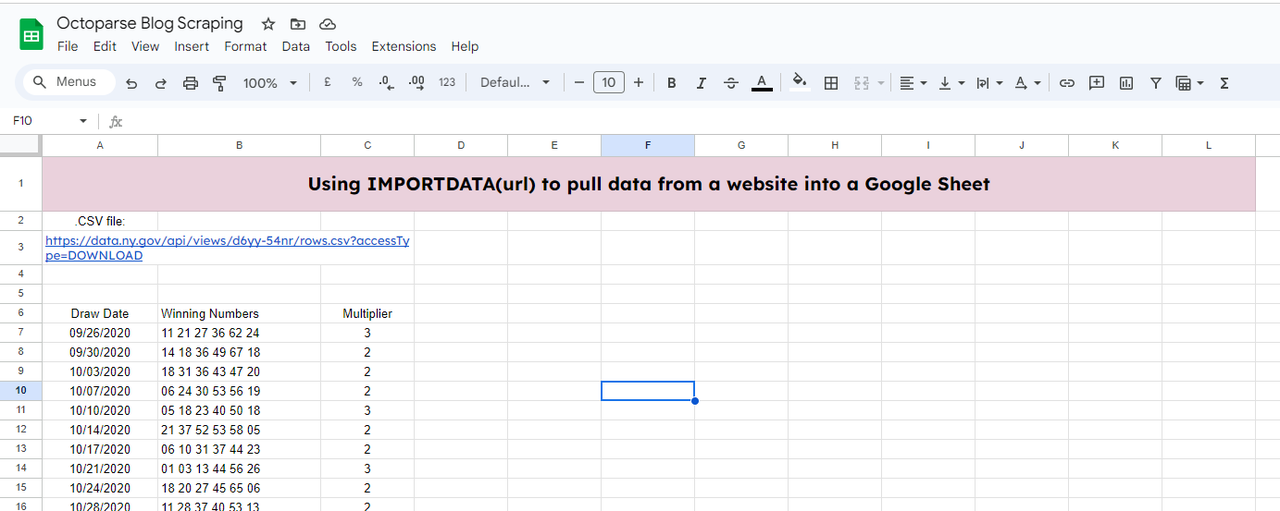

Methode 3: Verwenden von ImportDATA in Google Spreadsheets

Die Funktion IMPORTDATA importiert Daten von einer angegebenen URL im CSV- (Comma-Separated Values) oder TSV-Format (Tab-Separated Values) direkt in Google Tabellen.

Sie benötigen lediglich eine URL Ihrer Zielwebsite. Ganz einfach, oder?

Nehmen wir an, wir müssen Daten von der Website scrapen: https://catalog.data.gov/dataset/?res_format=CSV

Auf der Website können wir die CSV-Datei über den Link https://data.wa.gov/api/views/f6w7-q2d2/rows.csv?accessType=DOWNLOAD sehen (fahren Sie mit der Maus über die Schaltfläche „CSV“ und klicken Sie mit der rechten Maustaste, um die Adresse zu kopieren).

Um die Daten in Ihre Google Tabellen zu importieren, müssen Sie zunächst ein neues Tabellenblatt erstellen, wie wir es in den letzten beiden Methoden getan haben. Und verwenden Sie die folgende Funktion:

=IMPORTDATEN(A3,“,”“)

A3: Hier befindet sich der Link zu Ihrer CSV-Datei.

„,“: trennt die Datenfelder in der importierten Datei

Anschließend erhalten Sie die importierten Daten.

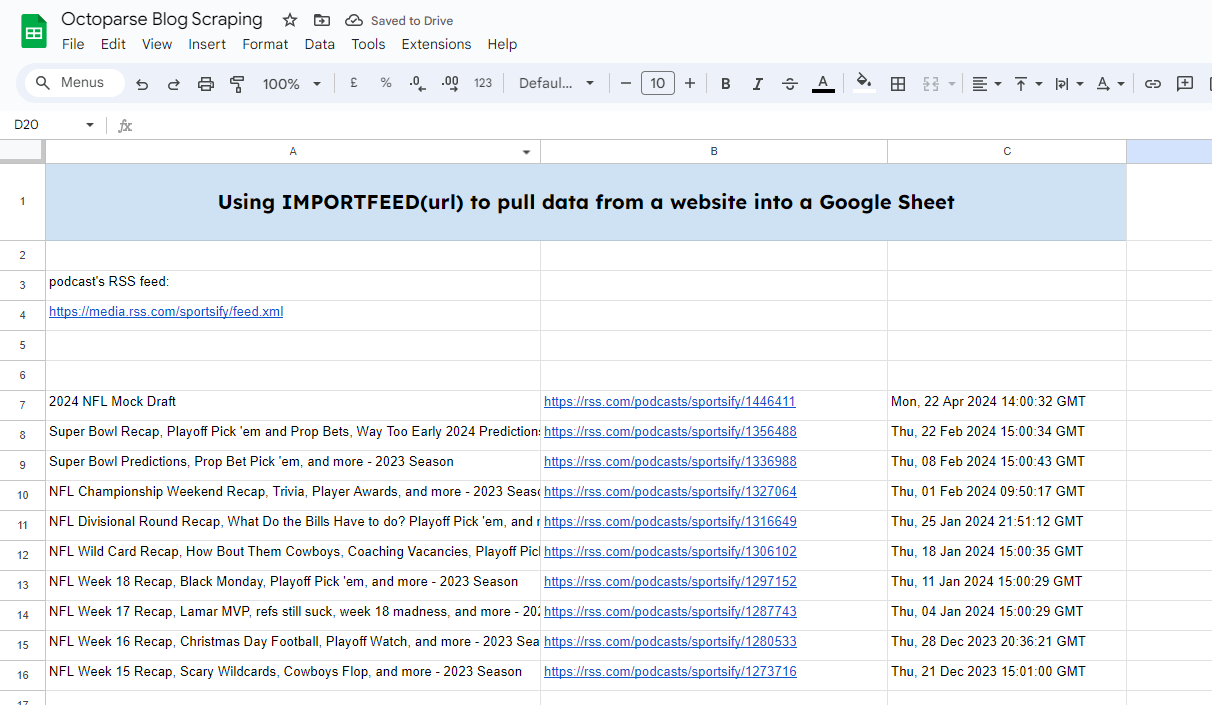

Methode 4: Verwenden ImportFeedin Google Tabellen

Die Funktion IMPORTFEED ruft RSS- oder ATOM-Feed-Daten von einer bestimmten URL ab.

Es sieht so aus:

=IMPORTFEED(URL, [Abfrage], [Header], [Anzahl_Elemente])

- url: Die URL des RSS- oder ATOM-Feeds.

- Abfrage: [Optional] Eine Abfrage zum Abrufen bestimmter Elemente. Der Standardwert ist

""(leere Zeichenfolge), wodurch alle Elemente abgerufen werden. - Header: [Optional] Ob Header eingeschlossen werden sollen. Der Standardwert ist

TRUE. - num_items: [Optional] Die Anzahl der abzurufenden Elemente. Der Standardwert ist 20.

Dazu benötigen wir den RSS-Feed eines Podcasts: https://rss.com/podcasts/sportsify/

Geben Sie dann die Funktion ein:

=IMPORTFEED(A4,“““,““,10)

Hier habe ich den RSS-Feed-Link in A4 eingegeben. Und ich möchte 10 Feeds herausziehen.

Und Sie erhalten das Ergebnis ganz schnell.

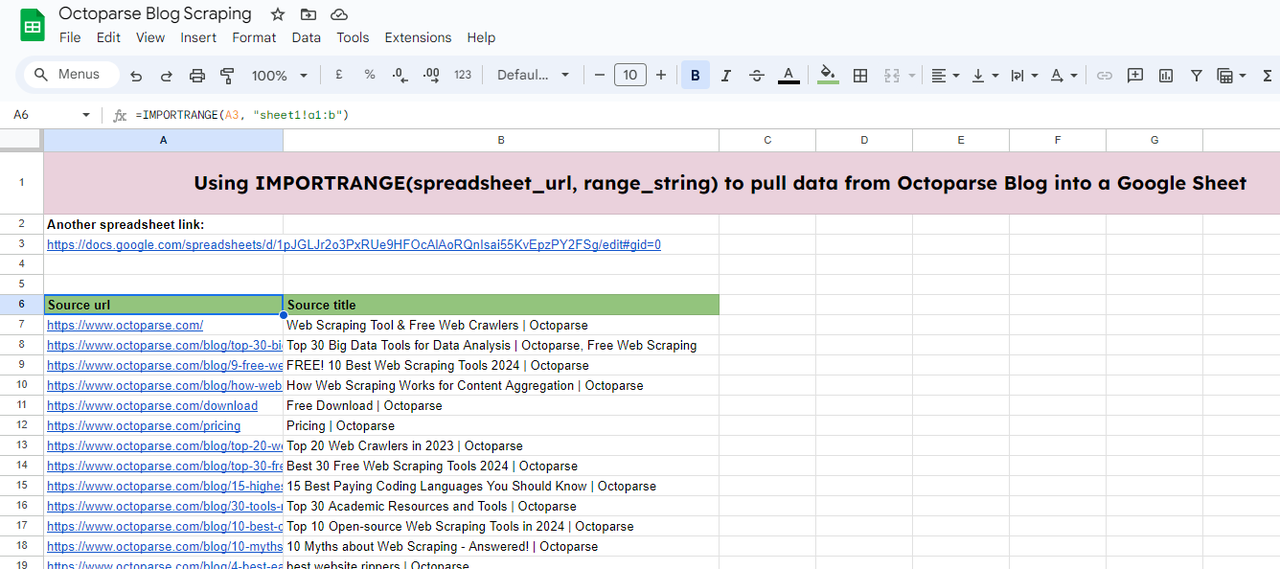

Methode 5: Verwenden von ImportRange in Google Spreadsheets

Mit der Funktion IMPORTRANGE in Google Tabellen können Sie Daten aus einer Google Tabellen-Tabelle in eine andere importieren. Dies ist besonders nützlich, um Daten aus mehreren Quellen zu konsolidieren oder Daten über verschiedene Tabellen hinweg zu teilen und dabei die dynamische Verknüpfung beizubehalten.

So sieht es aus:

=IMPORTRANGE(Tabellenkalkulations-URL, Bereichszeichenfolge)

- spreadsheet_url: Die URL der Tabelle, aus der Sie Daten importieren möchten. Diese sollte in Anführungszeichen stehen.

- range_string: Eine Zeichenfolge, die den zu importierenden Zellbereich angibt. Dies erfolgt normalerweise im Format

"SheetName!A1:D10".

In diesem Beispiel muss ich Daten aus einer anderen Tabelle (https://docs.google.com/spreadsheets/d/1pJGLJr2o3PxRUe9HFOcAlAoRQnIsai55KvEpzPY2FSg/edit#gid=0) in die Tabelle importieren, die ich gerade bearbeite.

Geben Sie dazu die Funktion ein:

=IMPORTRANGE(A3, „Tabelle1!a1:b“)

- A3: Hier werden die Quelldaten gespeichert.

- sheet1!a1:b: Ich benötige die Daten aus sheet1 des Zielblatts. Und der Datenbereich reicht von Spalte A1 bis Spalte B.

Anschließend können Sie die Daten abrufen, nachdem der Ladevorgang abgeschlossen ist.

Einschränkungen von Google Sheets beim Web Scraping

Obwohl diese 5 Funktionen unseren Weg zum Importieren von Daten von Websites in Google Sheets vereinfachen, gibt es viele Einschränkungen.

Datenvolumen

Erstens können diese Funktionen keine großen Datenmengen importieren, die eine Paginierung erfordern. Wie Sie im IMPORTXML-Beispiel sehen, können wir nur eine Seite Daten extrahieren. Wenn Sie alle Seiten benötigen, müssen Sie dies durch kontinuierliches Ändern der URL tun.

Dynamischer Inhalt

Die oben genannten Funktionen können nur statische und strukturierte Daten scrapen. Dynamische Daten, die mit Javascript und AJAX geladen werden, sind für sie unerreichbar.

Ratenbegrenzungen

Wenn Sie die Daten zu häufig anfordern, kann dies zu einer Ratenbegrenzung von Google führen, die Sie vorübergehend an der weiteren Datenextraktion hindert.

Ständige Wartung

Da einige Funktionen zum Auffinden der Daten auf das HTML der Website angewiesen sind, sind Ihre Daten betroffen und werden ungültig, sobald sich die Struktur der Website ändert.

Alternative: Daten ohne Codierung scrapen

Wenn Sie mehr als nur eine Tabelle oder Liste mit Daten benötigen und keine Lust auf Skripte haben, ist eine No-Code-Web-Scraping-Software wie Octoparse möglicherweise die perfekte Lösung für Sie. Sie bietet eine automatische Erkennungsfunktion, mit der Sie Datenfelder automatisch erkennen können, und erweiterte Funktionen ermöglichen Ihnen weitere Anpassungen.

Octoparse bietet auch voreingestellte Daten-Scraping-Vorlagen für beliebte Websites wie Amazon, eBay, Google Maps, LinkedIn usw. Sie können zunächst eine Vorschau der Datenprobe anzeigen und mit wenigen Parametern und Klicks mit dem Scraping beginnen. Probieren Sie die folgenden Online-Scraping-Vorlagen für Google Maps aus:

https://www.octoparse.de/template/google-maps-scraper-listing-page-by-keyword

Weitere Funktionen, die Sie durch das benutzerdefinierte Scraping von Octoparse erhalten:

- Benutzerdefinierter Scraper-Dienst und Datendienst.

- Antiblockierungseinstellungen: CAPTCHAs, IP-Rotation, Benutzeragenten, Intervalle und Anmeldung.

- Komplexe Site verarbeitet: unendliches Scrollen, Dropdown, Hover, Wiederholen, AJAX-Laden.

- Cloud-Extraktion und Datenspeicherung.

- Kostenloser Plan und 14-tägige kostenlose Testversion für Standard- und Professional-Pläne.

- Pay-as-you-go-Residential-Proxys; über 99 Millionen IPs aus 155 Ländern.

- Sehr reaktionsschnelles Support-Team: 24/7 per Live-Chat in der Gegensprechanlage

- Integration von Drittanbieter-Apps über Octoparse RPA; API-Zugriff.

Lesen Sie das Octoparse-Hilfecenter, wenn Sie noch Fragen zum Scraping von Website-Daten haben. Wenn Sie einen Datendienst für Ihr Projekt suchen, ist der Octoparse-Datendienst eine gute Wahl. Wir arbeiten eng mit Ihnen zusammen, um Ihre Datenanforderungen zu verstehen und sicherzustellen, dass wir das liefern, was Sie wünschen.

Fazit

Google Tabellen bietet Anfängern eine einfache und effektive Möglichkeit, grundlegende Web-Scraping-Aufgaben ohne komplexe Programmierkenntnisse durchzuführen. Mit den Funktionen IMPORTXML und IMPORTHTML können Sie schnell strukturierte Daten von Websites extrahieren und zur Analyse in Ihre Tabelle importieren. Während diese Funktionen perfekt für das Scraping im kleinen Maßstab geeignet sind, können für komplexere Aufgaben erweiterte Tools wie Octoparse erforderlich sein , um Effizienz und Genauigkeit zu gewährleisten. Egal, ob Sie Produktpreise, Markttrends oder andere nützliche Daten scrapen, Google Sheets bietet einen hervorragenden Ausgangspunkt für einfaches Web Scraping.

👍👍 Wenn Sie Interesse an Octoparse und Web Scraping haben, können Sie es zunächst 14 Tage lang kostenlos ausprobieren.

Wenn Sie Probleme bei der Datenextraktion haben oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.