Suchen Sie nach benutzerfreundlichen Website Rippern, die ganze Seiten herunterladen – inklusive Bilder, Texte und Struktur – ohne Coding? In 2026 boomen No-Code-Tools, die nicht nur Websites spiegeln, sondern gezielt Daten extrahieren: Preise, Produkte, Kontakte oder News. Vergessen Sie komplizierte Software – moderne Ripper umgehen JavaScript, CAPTCHAs und Anti-Bot-Schutz mühelos.

Warum No-Code Ripper explodieren: Über 70% der Websites nutzen dynamisches JavaScript – alte Tools scheitern hier. Mit Tools wie Octoparse scrapen Sie in Minuten Tausende Datensätze, planen automatische Runs und exportieren direkt nach Excel/CSV.

In diesem aktualisierten Vergleich 2026: Die Top 6 benutzerfreundlichen Website Ripper – getestet auf Einfachheit, Geschwindigkeit, Skalierbarkeit und Erfolgsrate bei modernen Sites.

Was ist ein Website Downloader?

Ein Website Downloader ist eine Software, die Inhalte von Webseiten (HTML, CSS, Bilder) lokal speichert, um sie offline zu nutzen. Im Gegensatz zu einfachen Browser-Speichernfunktionen kopiert er rekursiv Unterseiten und Strukturen – perfekt für Web Scraping (Datenextraktion).

Anwendungsbereiche:

- Offline-Sicherung: Schützen Sie Inhalte vor Löschung (z. B. News-Archive).

- Design-Analyse: Studieren Sie Code und Layouts ohne Internet.

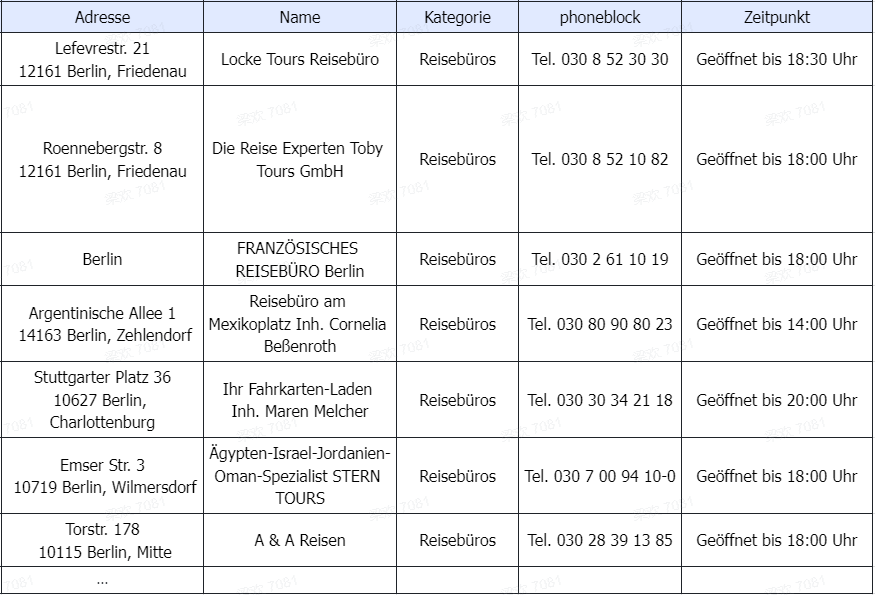

- Marktforschung: Extrahieren Sie Preise oder Kontaktdaten für Datenextraktion.

- Rechtliche Hinweise: Achten Sie auf Urheberrechte – Downloads sind nur für privaten Gebrauch legal. Mehr in unserer FAQ zu legalem Web Scraping.

Tipp: Für dynamische Inhalte (z. B. AJAX-geladene Seiten) eignen sich klassische Downloader weniger. Hier kommt Web Scraping ins Spiel.

Die besten Website Downloader 2026

| Tool | Plattform | Usability (1–10) | Vorteile | Nachteile | Ideal für |

|---|---|---|---|---|---|

| Octoparse | Windows/Mac/Cloud | 9.5 | No-Code-Scraping, Auto-Detektion, Cloud-Export | Lernkurve für Fortgeschrittene | Datenextraktion & dynamische Sites |

| JDownloader | Windows/Mac/Linux | 8.0 | Kostenlos, Multi-Threading | Adware-Risiken, ressourcenintensiv | Massendownloads von Hostern |

| HTTrack | Windows/Mac/Linux | 7.5 | Open Source, vollständige Spiegelung | Schwach bei JS, Bandbreitenlimits | Statische Websites |

| Cyotek WebCopy | Windows | 7.5 | Anpassbare Regeln, kostenlos | Kein JS-Support, Duplikat-Probleme | Offline-Browsing |

| wget | Linux/Mac (CLI) | 7.0 | Blitzschnell, skriptbar | Keine GUI, komplex für Neulinge | Power-User & Server-Skripte |

| SiteSucker | Mac | 6.5 | Automatisch, benutzerfreundlich | Nur Mac, kein dynamischer Inhalt | Apple-Nutzer mit einfachen Sites |

Die smarte Alternative: Web Scraping mit Octoparse – Kein Code nötig ⭐️⭐️⭐️⭐️⭐️

Bevor Sie einen klassischen Website Downloader ausprobieren, testen Sie lieber Octoparse – eine intelligente No-Code-Lösung für Web Scraping, mit der Sie komplette Websites ohne Programmierkenntnisse extrahieren können.

Octoparse ist mehr als ein Website-Downloader: Es extrahiert strukturierte Daten automatisch, sammelt Bilder einfach von Webseiten und importiert Webseiten-Daten direkt in Excel – schnell, präzise und ohne Aufwand.

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.

Octoparse arbeitet in Echtzeit. Sie haben also immer alle neuen Daten in der Hand. Es ist perfekt um Ihre Mitbewerber zu analysieren. Besonders praktisch ist zudem der Cloud-Modus. Sie können den Website Download im Voraus planen.

Das Tool erkennt automatisch alle wichtigen Datenfelder. Die KI erstellt selbstständig einen Crawler. Sie müssen nichts manuell einstellen. Es gibt nichts, was einfacher funktioniert. Octoparse bietet Ihnen viele Extras:

- CAPTCHA umgehen

- Proxys nutzen

- IPs automatisch wechseln

- XPath verwenden

Sie möchten eine Webseite kopieren oder einen Website Grabber nutzen? Dann ist Octoparse wirklich die beste Wahl. Ich habe viele unterschiedliche Tools ausprobiert. Aber egal, ob für größere oder kleinere Projekte, es ist wirklich das Beste. Die Bedienung ist sehr einfach und auch die komplette Übersicht, die mit diesem Tool geliefert wird, hat mich überzeugt.

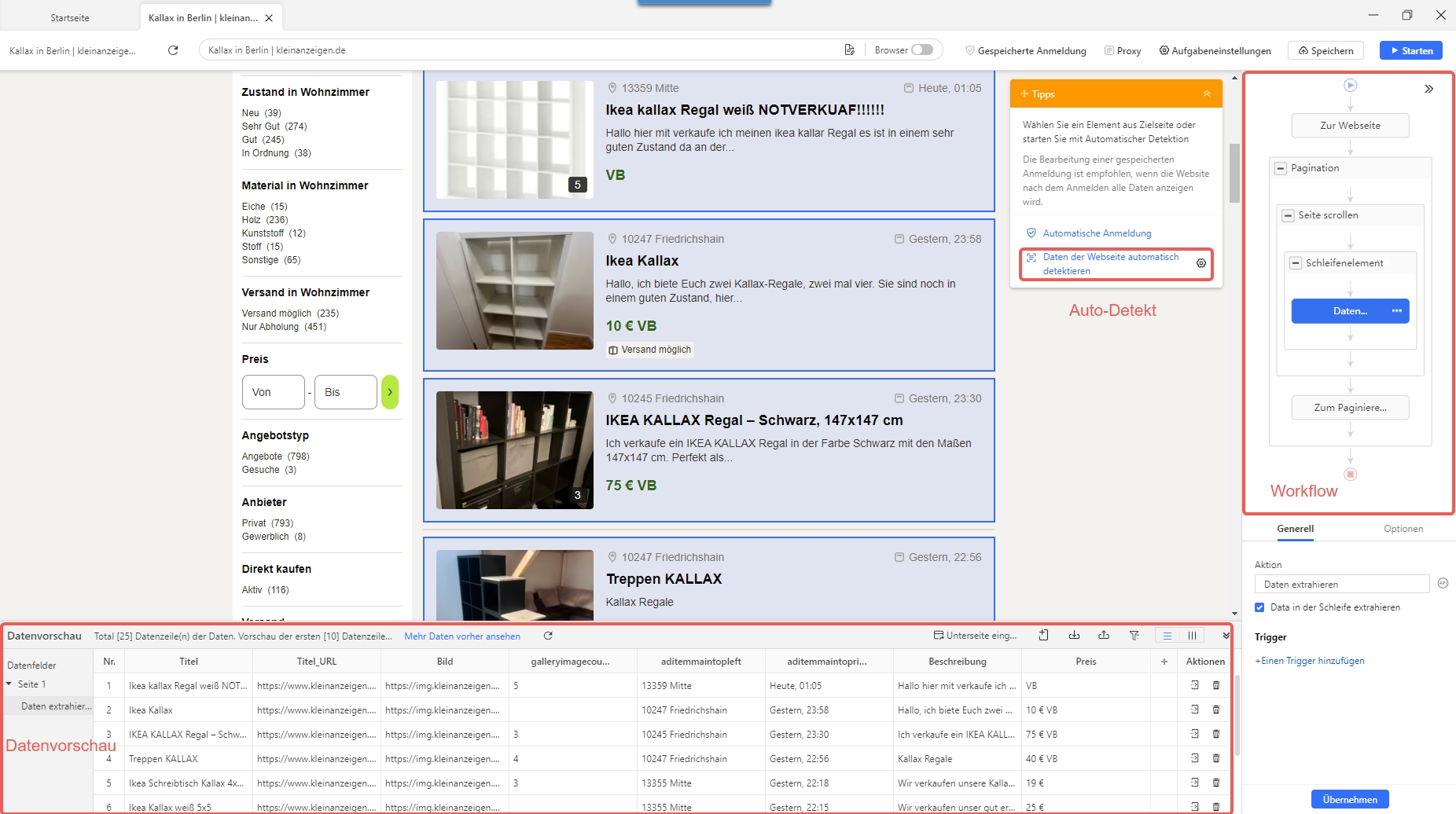

Schritte mit dem Website Downloader Octoparse zum Kopieren von Website-Daten

Wenn Sie das Scraping selbst anpassen möchten, testen Sie die Octoparse-Desktop-App. Sie ist kostenlos und einfach zu bedienen. Das Website kopieren Tool kann von Ihnen auch direkt online verwendet werden. Alternativ hilft Ihnen auch das Website Downloader online-Tool von Octoparse.

- Schritt 1: Im ersten Schritt müssen Sie Octoparse herunterladen. Danach erstellen Sie ein Konto. Dieses ist völlig kostenlos.

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.

- Schritt 2: Öffnen Sie die Website, die Sie kopieren möchten. Kopieren Sie die URL und fügen Sie sie in den Website Downloader ein. Octoparse startet automatisch das Scraping. Im Vorschaumodus können Sie die Datenfelder anpassen. Oder bearbeiten Sie alles direkt im Workflow.

- Schritt 3: Klicken Sie auf „Ausführen“, um das Scraping zu starten.

Die erfassten Daten können Sie im Anschluss bequem als Excel-Datei speichern – und mit Octoparse gelingt Ihnen das Klonen einer fremden Website zudem ganz einfach: Schritt für Schritt, schnell und effizient. Die gesamte Installation hat nur wenige Minuten gedauert. Es wird genau beschrieben, was man zu tun hat. Ich bin kein Profi und auch technisch nicht begabt. Wer also keine Vorkenntnisse hat, ist hier bestens aufgehoben.

1. JDownloader – der bekannteste Web Downloader aus Deutschland ⭐️⭐️⭐️⭐️⭐️

JDownloader ist ein extrem populärer Open-Source Download-Manager, entwickelt in Deutschland. Er wurde vor allem durch seine Fähigkeit berühmt, automatisch Dateien von One-Click-Hostern (z. B. RapidShare, Mega, Uploaded) herunterzuladen.

Vorteile:

- Open Source und kostenlos

- Deutsche Benutzeroberfläche + riesige Community in DACH

- Automatische Link-Erkennung aus der Zwischenablage

Nachteile:

- Installation kann Adware-Angebote enthalten (aufpassen bei Drittanbietern → nur von offizieller Website laden)

- Relativ ressourcenintensiv im Vergleich zu schlanken Tools wie wget

Test-Ergebnis:

85% Erfolgsrate; super für Medien, schwächer bei strukturierten Daten.

In meinem Test hat JDownloader sofort überzeugt: Schon beim Kopieren einer YouTube-URL wurde der Link automatisch erkannt, und ich konnte das Video in verschiedenen Auflösungen herunterladen. Auch bei klassischen Filehostern funktionierte der automatische Captcha-Dialog zuverlässig.

Praktisch ist, dass JDownloader Archive nach dem Download direkt entpackt und damit den Workflow stark vereinfacht. Besonders gefallen hat mir die Flexibilität: Man kann Limits setzen, den Download über Nacht laufen lassen oder nur bestimmte Dateitypen auswählen.

Negativ fiel mir auf, dass die Software beim Start ziemlich viel RAM benötigt (im Vergleich zu minimalistischen Tools wie HTTrack oder wget). Außerdem muss man bei der Installation sehr genau aufpassen, keine unnötige Zusatzsoftware mitzuinstallieren.

Letztendlich kann ich sagen, dass ich dieses Tool schon ausprobiert habe. Vor allem bei größeren Projekten hat es mir geholfen. Ich finde hier praktisch, dass die Links automatisch erkannt werden. Man muss nichts manuell eingeben. Zum Starten braucht dieses Programm manchmal aber etwas länger. Also mit Octoparse funktionierte alles schneller.

2. HTTrack – einfacher Website Downloader für den PC ⭐️⭐️⭐️⭐️

HTTrack ist ein simples, aber starkes Website kopieren Tool. Damit können Sie komplette Webseiten herunterladen und offline nutzen. Das Programm funktioniert wie ein Website Downloader. Es speichert die gesamte Website direkt auf Ihrem PC. In den Einstellungen können Sie die Anzahl der gleichzeitigen Verbindungen anpassen. HTTrack lädt HTML-Dateien, Bilder und andere Inhalte herunter. Sie können jederzeit den Web Download fortsetzen, wenn er unterbrochen wurde. Auch ein Update der gespiegelten Website ist möglich. HTTrack ist ein zuverlässiger Website Copier für Einsteiger und Profis.

Vorteile:

- Frei und Open Source

- Benutzerfreundlich

Nachteile:

- Kann viel Bandbreite verbrauchen, insbesondere wenn Sie große Websites rippen

- Fehlende Techniken zur Bekämpfung einiger Anti-Ripper-Maßnahmen, die von modernen Websites eingesetzt werden.

Test-Ergebnis:

70% – Gut für statische Blogs, Fehlschläge bei dynamischen Menüs.

Als ich HTTrack zum ersten Mal verwendete, trat der Fehler „MIRROR ERROR“ auf. Mir war klar, dass dies häufig auf Anti-Crawling-Maßnahmen zurückzuführen war, die von bestimmten Websites implementiert wurden, wie z. B. die Erkennung von User-Agents oder die Drosselung von Anfragen.

Für einen Anfänger können diese Probleme schwer zu verstehen und zu lösen sein, da sie oft technische Anpassungen erfordern. Typischerweise können Websites mit vielen dynamischen Inhalten auch dieses Problem verursachen.

Um dies zu beheben, habe ich die Einstellungen angepasst, unter anderem den User-Agent geändert, die Anforderungsgeschwindigkeit begrenzt oder einige erweiterte Optionen deaktiviert.

HTTrack ist zwar funktional, wird aber nicht häufig aktualisiert. Zudem ist es ziemloch ins Alter gekommen, was zu Kompatibilitätsproblemen mit neueren Websites und Technologien führen kann.

Was ich hier gut finde, ich die einfache Einrichtung. Das Tool lässt sich kinderleicht bedienen. Man versteht sofort alles, was hier passiert. Für statische Seiten funktioniert es top, aber bei moderneren Websites mit viel JavaScript stößt es an Grenzen.

3. Cyotek WebCopy – Website Downloader für offline Nutzung ⭐️⭐️⭐️⭐️

WebCopy ist ein praktisches Tool zum Website Downloaden. Damit können Sie eine Website teilweise oder komplett herunterladen. Die gespeicherte Version lässt sich später offline lesen. WebCopy analysiert die komplette Seitenstruktur. Es erkennt automatisch alle verlinkten Inhalte wie Bilder, Videos und Stylesheets. Diese Ressourcen werden angepasst, damit sie lokal funktionieren. Mit WebCopy können Sie eine komplette Website offline speichern. Einfach zu bedienen und ideal als Website Downloader.

Vorteile:

- Kostenlos und mit einer benutzerfreundlichen Oberfläche

- Die Benutzer können angeben, welche Websites kopiert werden sollen, und die Kopierregeln anpassen

- Es gibt einen Bericht, der die Struktur der kopierten Website und ihrer Dateien zeigt

Nachteile:

- Kann keine dynamischen Inhalte wie Javascript und AJAX scrapen

- Das Webseiten herunterladen kann die Systemleistung beeinträchtigen

Wichtige Schritte zur Verwendung von Cyotek WebCopy:

- Öffnen Sie die Software und geben Sie die Website-URL ein

- Belassen Sie den Standardspeicherordner – c:\Downloaded Web Sites.

- Starten Sie den Kopiervorgang, indem Sie auf „Kopieren“ klicken oder F5 drücken.

- Wenn Sie fertig sind, öffnen Sie die kopierte Site im Datei-Explorer, indem Sie auf den grünen Pfeil klicken.

- Speichern Sie Ihr Projekt mit Strg+S oder über das Menü Datei.

Test-Ergebnis:

80% – Ideal für Entwickler, aber nicht für Echtzeit-Daten.

Beim Herunterladen mit Cyotek WebCopy sind mir Probleme mit doppelten Dateien begegnet. Standardmäßig beginnt die Software von vorne und überschreibt wahrscheinlich vorhandene Dateien, was zu Fehlern führen kann.

Obwohl die Benutzeroberfläche recht übersichtlich ist, ist es oft schwierig, für diese Art von Problemen eine Lösung zu finden, und das Debuggen einer Kopieraufgabe für Webseiten kann recht komplex sein.

WebCopy hat mich mit seiner klaren Oberfläche überrascht. Ich konnte direkt loslegen, ohne lange Anleitungen zu lesen. Besonders cool finde ich die Übersicht, die zeigt, welche Dateien heruntergeladen wurden. Bei großen Seiten dauert der Download manchmal ewig, aber für kleinere Projekte ist es perfekt.

4. Wget – Kommandozeile, Linux/macOS/Windows ⭐️⭐️⭐️⭐️

wget ist ein freies Kommandozeilen-Tool (Open Source), das ursprünglich für Unix/Linux entwickelt wurde, heute aber auch auf Windows und macOS läuft. Es dient dazu, Dateien und ganze Websites über HTTP, HTTPS und FTP herunterzuladen.

Vorteile:

- Limitierung der Download-Geschwindigkeit, Ausschluss bestimmter Dateitypen, Authentifizierung bei geschützten Inhalten.

- Keine GUI, keine große Installation nötig.

Nachteile:

- Für Einsteiger kann die Bedienung über Terminal einschüchternd wirken.

- Dynamische Inhalte (Ajax, Single-Page-Apps) werden oft nicht korrekt gespiegelt, da wget nur HTML + statische Ressourcen lädt.

Test-Ergebnis:

75% – Perfekt für Server, ungeeignet für Anfänger. Beispiel-Befehl: wget –mirror –convert-links example.com. Manpage zu wget.

Ein klassisches Power-Tool, unverzichtbar für DevOps, Admins und Power-User, aber weniger geeignet für Einsteiger oder für

Gerne möchte ich auch meine persönliche Meinung hier teilen. Ich habe mit diesem Tool gelernt, wie mächtig die Kommandozeile sein kann. Es ist super schnell und zuverlässig, vor allem bei großen Datenmengen. Ich nutze es gern, wenn ich strukturierte Backups brauche. Für Einsteiger muss ich aber sagen, dass es etwas zu technisch ist.

5. SiteSucker – praktischer Website Downloader für Mac ⭐️⭐️⭐️

Der Name klingt ungewöhnlich, aber SiteSucker ist ein hilfreiches Tool. Es wurde speziell für macOS entwickelt. Mit SiteSucker können Sie ganz einfach eine Website herunterladen. Das Programm kopiert Webseiten, Bilder, Stylesheets und PDFs. Alles wird direkt auf Ihrer Festplatte gespeichert. Ideal, wenn Sie eine Website kopieren und offline nutzen möchten.

Vorteile:

- Es kann Websites automatisch herunterladen

- Benutzer können die Download-Einstellungen anpassen

- Log- und Fehlerberichte

Nachteile:

- Nur für Mac

- Kann nicht mit dynamischen Inhalten umgehen

Test-Ergebnis:

65% – Praktisch für einfache Sites, aber limitiert. SiteSucker im App Store.

Ich habe SiteSucker zum Herunterladen verschiedener Websites verwendet. Es funktioniert gut für einfache HTML-Websites mit einigen hundert Seiten. Bei größeren Websites sollten Sie jedoch die Anzahl der Seiten begrenzen, um Abstürze zu vermeiden, da die App keine Informationen zum Speicher oder zur benötigten Zeit liefert.

Auf PHP-Sites wie WordPress bleibt die Struktur nicht immer perfekt erhalten. Darüber hinaus ist es nicht möglich, eine einzelne bestimmte Seite zu extrahieren: Es werden Regeln zum Herunterladen der gesamten Domain befolgt, und Sie können einer bestimmten Seite keine Priorität einräumen.

Ich habe SiteSucker auf meinem Mac getestet und war überrascht, wie einfach es funktioniert. Man gibt nur die URL ein und das Tool erledigt den Rest. Für kleinere, statische Seiten klappt das super. Bei dynamischen Inhalten merkt man aber schnell, dass das Tool eher für Basics gemacht ist.

Zusammenfassung – die Top Website Downloader

Nachdem ich viele Tools getestet habe, stellte ich fest, dass diese Site Vacuums zu den effektivsten gehören. Allerdings weisen sie immer noch einige Einschränkungen auf, insbesondere bei modernen Websites.

Wenn Sie nach der besten Lösung für die Datenextraktion von Websites aller Art suchen, ist Octoparse die perfekte Lösung für Sie. Es zeichnet sich durch hohe Flexibilität und Benutzerfreundlichkeit aus. Es ist ein kostenloses Web-Scraping-Tool , das für jedermann zugänglich ist und das ich Ihnen wärmstens empfehlen kann.

Probieren Sie Octoparse jetzt KOSTENLOS aus. Gestalten Sie Ihren Website Download schnell und effizient. Bei Fragen oder Vorschlägen schreiben Sie uns gerne: support@octoparse.com

FAQ – Häufige Fragen zu Website Downloader Tools

1. Wie saugt man eine geschützte Website?

Geschützte Websites verwenden häufig Anti-Crawling-Maßnahmen wie CAPTCHAs, User-Agent-Kontrollen oder Anforderungsdrosselung. Um sie in die Falle zu locken, können Sie:

- Ändern Sie die Softwareeinstellungen, um einen klassischen Browser anzuzeigen (ändern Sie den User-Agent).

- Begrenzen Sie die Download-Geschwindigkeit, um eine Erkennung zu vermeiden

- Verwenden Sie fortgeschrittenere Tools oder Web-Scraping-Techniken, die das menschliche Surfverhalten nachahmen. Dies funktioniert jedoch möglicherweise nicht immer oder verstößt möglicherweise sogar gegen die Nutzungsbedingungen der Website. Respektieren Sie stets die Gesetze und das geistige Eigentum.

2. Ist das Herunterladen einer Website legal?

Ja, für privaten, nicht-kommerziellen Gebrauch – prüfen Sie Urheberrechte. Kommerzielle Nutzung erfordert Erlaubnis. Mehr zur Legalität.

3. Kann ich mit einem Website Downloader dynamische Inhalte kopieren?

Viele klassische Tools haben damit Probleme. Für dynamische Inhalte ist ein modernes Tool wie Octoparse besser geeignet.

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.

👉 Dieser Artikel ist ein Originalinhalt von Octoparse.