Funktionen der Sportnachrichten

Sportnachrichten liefern eine Fülle von Daten und Informationen über verschiedene Aspekte des Sports, wie zum Beispiel die Ergebnisse von Spielen und Wettkämpfen, Statistiken zu einzelnen Spielern oder Teams, Verletzungen und andere wichtige Ereignisse, die sich auf den Verlauf eines Spiels oder einer Saison auswirken können.

Diese Daten werden von verschiedenen Akteuren im Sport genutzt, um unterschiedliche Ziele zu erreichen. Einige Beispiele dafür sind:

– Journalisten und Reporter verwenden Sportdaten, um Berichte und Geschichten über Spiele, Teams und Spieler zu schreiben.

– Trainer und Athleten verwenden Sportdaten, um ihre Leistungen zu analysieren, Schwächen zu identifizieren und ihre Strategien und Taktiken zu verbessern.

– Fans verwenden Sportdaten, um ihre Lieblingsteams und -spieler zu verfolgen, Vorhersagen zu treffen und ihre Fantasy-Sportteams zu erstellen.

– Wettbewerber und Wetttipp-Spieler verwenden Sportdaten, um Wetten und Vorhersagen zu treffen.

– Unternehmen und Werbetreibende verwenden Sportdaten, um ihre Zielgruppe besser zu verstehen und gezielte Werbung zu schalten.

Insgesamt können Sportdaten verwendet werden, um bessere Entscheidungen zu treffen, die Leistung zu verbessern und ein tieferes Verständnis für die Welt des Sports zu entwickeln.

Top 5 Scraping Tools für Extraktion der Sportdaten

1. Octoparse

Octoparse ist ein leistungsfähiges Web Crawler Tool zum Extrahieren der Webdaten. Mit einem benutzerfreundlichen Interface ist die Software speziell für Nicht-Codierer eingerichtet worden. Folgend ist ein Video über Octoparse, in das die wichtigsten Funktionen und einfache Schritte gezeigt werden, damit Sie die Software besser kennenlernen können.

Hauptmerkmale von Octoparse Web Crawler:

–Zeitgesteuerte Wolkenextraktion: Extrahieren der Echtzeitdaten aus Webseiten.

– Datenbereinigung: Integrierte Regex- und XPath-Konfiguration, um Daten automatisch zu bereinigen.

– Umgehung von Blockierungen: Cloud-Dienste und IP-Proxy-Server zur Umgehung von ReCaptcha und Sperrungen.

Einfache Schritte zur Datenerfassung mit Octoparse Web Crawling Tool

– Vorgefertigte Scraper: zum Scrapen von Daten aus beliebten Websites wie Amazon, eBay, Twitter, Transfermarkt.de Gesamtspielplan Scraper usw.

https://www.octoparse.de/template/transfermarkt-de-gesamtspielplan-scraper

– Automatische Erkennung: Geben Sie die Ziel-URL in Octoparse ein und Octoparse erkennt automatisch die strukturierten Daten und scrapt sie zum Herunterladen.

– Datenformat: EXCEL, XML, HTML, CSV, oder zu Ihren Datenbanken über API.

2. ParseHub

Parsehub ist ein Web Crawler, der mithilfe von AJAX-Technologie, JavaScript, Cookies usw. Daten von Websites sammelt. Seine maschinelle Lerntechnologie kann Webdokumente lesen, analysieren und dann in relevante Daten umwandeln.

Hauptmerkmale von Parsehub:

– Integration: Google Sheets, Tableau

– Datenformat: JSON, CSV

– Gerät: Mac, Windows, Linux

3. WebHarvy

WebHarvy ist eine Point-und-Click Web Scraping Software. Sie ist für Nicht-Programmierer konzipiert.

WebHarvy wichtige Funktionen:

✔️ Scrapen Sie Texte, Bilder, URLs und E-Mails von Websites.

✔️ Proxy-Unterstützung ermöglicht anonymes Crawlen es und verhindert, von Webservern blockiert zu werden.

✔️ Datenformat: XML-, CSV-, JSON- oder TSV-Datei. Benutzer*innen können die gesammelten Daten auch in eine SQL-Datenbank exportieren.

4. HTTrack

HTTrack ist eine einfache, aber leistungsstarke Website-Ripper-Freeware. Es kann die gesamte Website aus dem Internet auf Ihren PC herunterladen. Sie können die Anzahl der gleichzeitigen Verbindungen während des Herunterladens unter der “Einstellungsoption” kontrollieren. Mit HTTrack können Sie Fotos, Dateien, HTML-Code erhalten, die aktuelle gespiegelte Webseite aktualisieren und unterbrochene Downloads wieder aufnehmen.

5. Getleft

Getleft ist ein kostenloser und benutzerfreundlich Website-Downloader, der zum Downloaden der Inhalte einer Website verwendet werden kann. Nachdem Sie Getleft ausgeführt haben, können Sie eine URL eingeben und die Dateien auswählen, die Sie erhalten möchten. Dann können Sie mit dem Herunterladen der Website beginnen.

Beispiel: Kicker.de Scraper erstellen mithilfe von Octoparse

Vor dem Scraping sollte man die Ziel-URL vorbereiten. In disem Beispiel nehmen wir die URL www.kiker.de.

Draus werden alle Nachrichten auf der Startseite abgerufen.

Schritt 1 Downloaden und öffnen Sie Octoparse.

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.

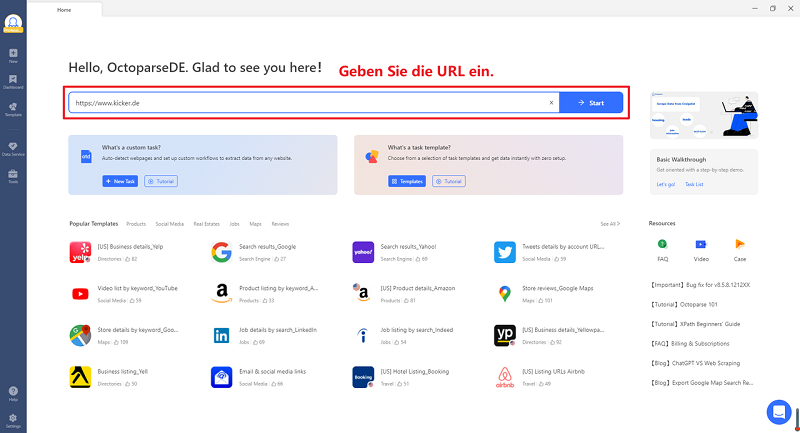

Schritt 2 Geben Sie die obige URL ein und Octoparse fängt an, die URL zu analysieren und automatisch alle Code der Seite zu überprüfen.

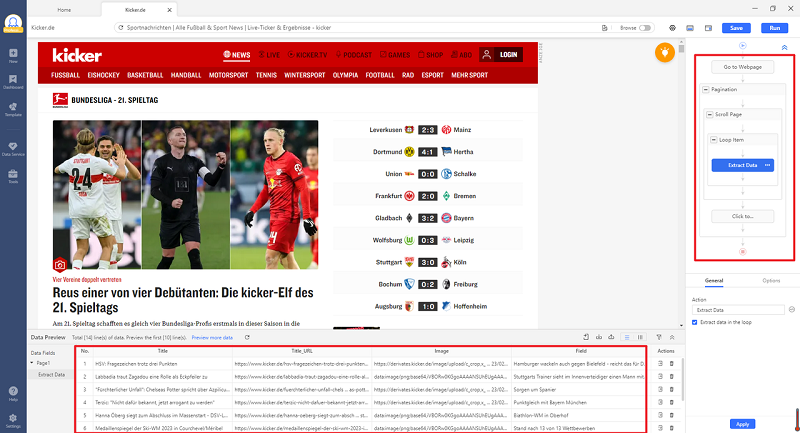

Schritt 3 Nach Auto-Detection sind alle Datenfeldern im unten angezeigt. Klicken Sie auf “Creat workflow” zu Erstellen eines Task-Workflows.

Schritt 4 Der Workflow rechts zeigt die Scraper Logik. Die extrahierten Daten auf der Seite sind in rot dargestellt und alle Datentitel sind nach Ihrem Wunsch umbenennenbar.

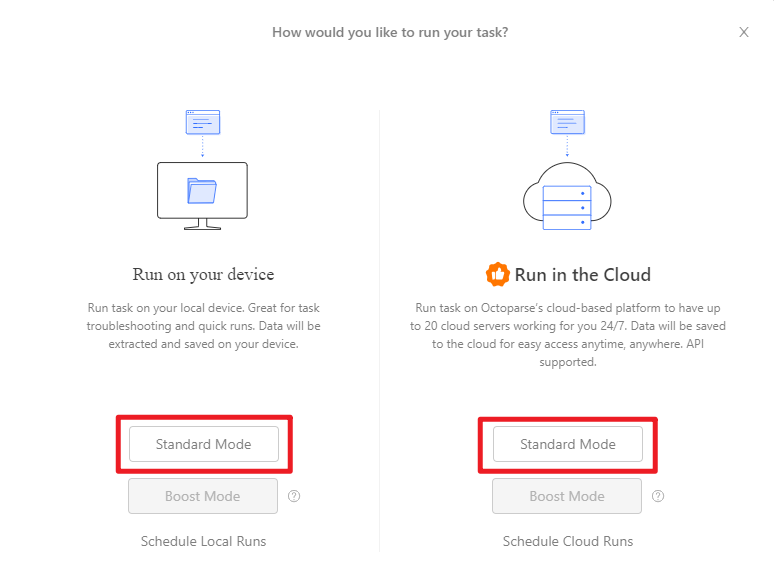

Schritt 5 Klicken Sie auf “Run”, um den Task zu starten. Hier sind Device Mode und Cloud Mode zu wählen.

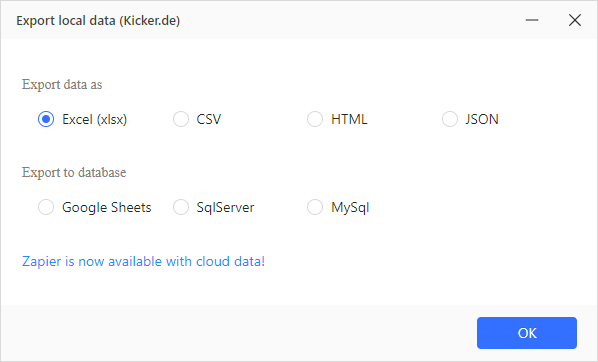

Schritt 6 Daten exportieren in Excel, CSV, HTML oder JSON. Zapier ist auch verfügbar in Cloud Mode.

Schritt 7 Hier ist ein Beispiel von Sportnachrichten aus kicker.de.

FAQ

1. Kann ich mit Octoparse auch Live-Sportdaten von Kicker.de scrapen, oder nur archivierte Inhalte?

Ja, Octoparse eignet sich sowohl für das Scraping von archivierten Sportnachrichten als auch für Live-Daten von Kicker.de. Dank seiner Cloud-Scraping-Funktion und der Möglichkeit, Tasks auszuführen (z. B. in festen Intervallen), kann das Tool kontinuierlich nach Aktualisierungen auf der Seite suchen – sei es nach Live-Spielresultaten, Echtzeit-Statistiken oder neu veröffentlichten Nachrichten. Die extrahierten Daten können in Echtzeit exportiert oder über APIs in Datenbanken integriert werden.

2. Brauche ich Programmierkenntnisse, um mit Octoparse Sportdaten von Kicker.de zu scrapen?

Nein, Programmierkenntnisse sind nicht erforderlich. Octoparse ist als “click-and-drop”-Tool entwickelt worden, das sich an Nutzer ohne technische Vorkenntnisse richtet. Das Tool erkennt automatisch Strukturen auf der Seite von Kicker.de (z. B. Überschriften, Texte, Tabellen) und generiert einen Scraping-Workflow mit wenigen Klicks. Nutzer können Felder umbenennen, Filter einrichten oder den Scraping-Prozess anpassen – alles über eine intuitive grafische Oberfläche, ohne Code schreiben zu müssen.

3. Welche Formate stehen zur Verfügung, um die gescrapten Daten von Kicker.de zu exportieren?

Octoparse unterstützt eine Vielzahl von Exportformaten für die von Kicker.de extrahierten Sportdaten, darunter:

- Structurierte Tabellenformate: CSV, Excel (XLSX), Google Sheets.

- Datenbank-kompatible Formate: SQL, JSON, XML.

- Web-integrierte Formate: HTML oder direkte API-Exporte zu Diensten wie Zapier, Tableau oder Cloud-Datenbanken (z. B. Google BigQuery).

Dadurch lassen sich die Daten flexibel weiterverarbeiten – sei es für Analysen in Excel, Visualisierungen in Tableau oder die Integration in eigene Anwendungen.

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

👍👍 Wenn Sie Interesse an Octoparse und Web Scraping haben, können Sie es zunächst 14 Tage lang kostenlos ausprobieren.

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.