Web Daten Extraktion oder Web Scraping ist immerhin als eine der populären Methoden, nützliche Daten zu sammeln,um das Geschäft kostengünstig voranzutreiben, angesehen. Obwohl die Web Daten Extraktion schon seit langem existiert, wurde sie noch nie so haufig oder so zuverlässig wie heute. Hier ist der definitive Guide 2022 nachzuschauen, der besonders für die Anfänger bei der Erwerbung einer allgemeinen Vorstellung von Web Daten Extraktion hilfreich ist.

Was ist die Web Daten Extraktion?

Die Web Daten Extraktion ist eine techinische Methode, mit der die Daten auf Webseiten massiv und schnell kopiert werden. Man nennt diese Technologie auch Web Scraping, Daten Scraping, Web Crawling und andere. Die aus Webseiten extrahierten oder kopierten Daten können in einer Datei auf Ihrem Computer oder in einer Datenbank gespeichert werden.

Wofür ist die Web Daten Extraktion?

Mit Web Daten Extraktion können viele Unternehmen ihre Geschäfte besser und effizienter vorantreiben. In diesem Teil wird die Verwendung und Vorteile der Daten Extraktion in verschiedenen Branchen angezeigt.

Preisüberwachung der E-Commerce

Die Preisüberwachung kommt zu einem ganz wichtigen Mittel für die Bemühung um eine Geschäftsstrategie. Damit kann nicht nur die Preise von Ihren eignen Artikeln sondern auch die von den Kokurenten auf einem offenbaren Online-Verkaufsplattform nämlich Amazon, eBay, Lazada zur Überwachung gestellt werden. Auf solchen Plattformen sind außer Preis auch Inventar, Bewertungen und alle anderen Informationen für jedes Geschäft in transparenten, einfachen, rechtzeitigen und legalen Weisen zugängig. Das bedeutet, dass Sie sich nicht nur auf den Preis konzentrieren können, sondern auch andere Aspekte Ihrer Konkurrenz im Auge behalten können. Daher stehen Ihnen neben den Preisen mehr zur Verfügung. Die Preisüberwachung ist mehr als Preise.

Die meisten Einzelhändler und E-Commerce-Anbieter versuchen, so viele Informationen über ihre Produkte wie möglich online zeigen zu lassen, um den potenziellen Kunden anzuziehen. Dazu kommt die Datenextraktion zu einer wichtigen Möglichkeit, die für die Geschäftler hilfreich bei der Bewertung, ob es benötigt ist, alle Informationen herausgestellt werden müssen. Glücklicherweise können Sie auch diese Daten verwenden, um Ihre Strategie schnell und richtig machen.

Sie sollten auch Informationen wie Preis, Lagerbestände, Rabatte, Produktumsatz, neu hinzugefügte Artikel, neue Standorte, Produktkategorie usw. von Ihren Konkurrenten sammeln. Mit diesen Daten können Sie Ihr Geschäft mit den folgenden Vorteilen versorgen, die die Web Daten Extraktion bietet.

- Die Umsätze besser verwalten, die Artikel unter konkurrenzfähigerem Preis zur richtigen Zeit und auf geeignete Plattformen stellen.

- Konkurrenz Ihres Geschäfts erhöhen.

- Kostenmanagement verbessern durch den Vergleich der Preise von Konkurrenten und die Überwachung der Preise aus der Seite von Liferanten.

- Effektivere Preisstrategie entwickeln, insbesondere bei der Werbung zu Saison oder Ferien.

Marktanalyse

Fast jeder kann sein eigenes Geschäft online starten. Heutezutage kommen immer meher Unternehmen im Internet vor, was bedeutet, dass der Wettbewerb unter den Händlern insbesondere den Einzelhändlern härter wird. Um Ihr Unternehmen von der Masse abzuheben und nachhaltiges Wachstum zu erhalten, können Sie mehr tun, als nur Ihren Preis zu senken oder Werbekampagnen zu starten.

Sie könnten für ein Unternehmen in einer Anfangsphase produktiv sein, während Sie langfristig darauf achten sollten, was andere Spieler tun, und Ihre Strategien an die sich ständig verändernde Umgebung anpassen.

Sie können Ihre Kunden und Ihre Konkurrenten analysieren, indem Sie Produktpreise, Kundenverhalten, Produktbewertungen, Ereignisse, Lagerbestände und Anforderungen usw. sammeln. Mit diesen Informationen Sie erhalten Einblicke, wie Sie Ihren Service und Ihre Produkte verbessern und sich von Ihren Mitbewerbern abheben können.

Web Scraping Tools können diesen Prozess rationalisieren und Ihnen stets aktuelle Informationen für die Marketinganalyse zur Verfügung stellen.

Erhalten Sie ein besseres Verständnis der Anforderungen und Verhaltensweisen Ihrer Kunden und finden Sie dann einige spezifische Kundenbedürfnisse, um exklusive Angebote zu machen.

- Analysieren Sie Kundenbewertungen und Feedback zu Produkten und Dienstleistungen Ihrer Mitbewerber, um Ihr eigenes Produkt zu verbessern.

- Erstellen Sie eine vorausschauende Analyse, um zukünftige Trends vorherzusehen, zukünftige Strategien zu planen und Ihre Priorisierung rechtzeitig zu optimieren.

- Sammeln Sie die kopierten Produktbilder Ihrer Konkurrenten an, um die am besten geeigneten Möglichkeiten zur Differenzierung zu finden.

Leads-Generation

Es besteht kein Zweifel, dass die Fähigkeit, mehr Leads zu generieren, eine der wichtigsten Fähigkeiten ist, um Ihr Geschäft auszubauen. Wie kann man Leads effektiv generieren? Viele Leute sprechen darüber, aber nur wenige von ihnen wissen, wie man es macht. Die meisten Verkäufer suchen jedoch immer noch auf traditionelle, manuelle Weise nach Leads im Internet.

Heutzutage suchen intelligentere Verkäufer mit Hilfe von Web Scraping Tools nach Leads, deren Infos über soziale Medien, Yellow Page,Foren usw. zum Erhalten sind. Damit können Sie mehr Zeit für die Kontakte mit den hohen potenziallen Kunden sparen.

Wenn Sie einen Web Scraper verwenden, vergessen Sie nicht, die folgenden Informationen für die Lead-Analyse zu sammeln. Schließlich ist nicht jeder Lead es wert, Zeit damit zu verbringen. Sie müssen die Interessenten priorisieren, die bereit oder willens sind, von Ihnen zu kaufen.

- Persönliche Daten: Name, Alter, Ausbildung, Telefonnummer, Arbeitsstelle, E-Mail.

- Unternehmensinformationen: Branche, Größe, Website, Standort, Rentabilität.

Im Laufe der Zeit sammeln Sie viele Leads, sogar genug, um Ihr eigenes CRM aufzubauen. Mit einer Datenbank mit E-Mail-Adressen Ihrer Zielgruppe können Sie Informationen, Newsletter, Einladungen zu einer Veranstaltung oder Werbekampagnen in großen Mengen versenden. Aber Vorsicht vor zu Spam!

Ist Web Daten Extraktion legal?

Ist es legal, ein Web Datenextraktionstool zu verwenden? Die Antwort hängt davon ab, wie Sie die Daten verwenden möchten und ob Sie die Nutzungsbedingungen der Website befolgen. Mit anderen Worten, verwenden Sie sie innerhalb der Gesetze.

Es gibt einige häufige Beispiele für legale und illegale Aktivitäten mit Web Scraping Tools.

Sie dürfen:

- Web Scraping Tools verwenden.

- nur die Informationen auf den der Öffentlichkeit zugänglichen Websites wie soziale Medien, E-Commerce-Plattformen und Yellow Page sammeln.

- Gesammelte öffentliche Informationen erneut veröffentlichen.

Sie dürfen nicht:

- die Informationen der Benutzer*in an den Dritten geben.

- die Informationsrechte der Ziel-Webseite beschädigen.

- die Informationen zum kriminellen Ziel benutzen. (z. B. Wiederverkauf oder Wiederveröffentlichung von proprietären Informationen)

- andere schädlichen Benutzung gegen Personen oder Unternehmen.

Darüber hinaus dürfen Benutzer von Web Scraping nicht gegen die Nutzungsbedingungen, Gesetze und Vorschriften sowie die Urheberrechtserklärungen der Websites verstoßen. Auf der Website wird klar angegeben, welche Art von Daten verwendet werden können und wie Sie darauf zugreifen können. Diese Informationen finden Sie einfach auf der Startseite.

Wie funktioniert die Web Daten Extraktion?

Nachdem Sie wissen, was Sie von einem Web Scraping Tool profitieren können, möchten Sie vielleicht selbst eines bauen. Es ist wichtig, zuerst zu verstehen, wie ein Scraper funktioniert und worauf Webseiten aufgebaut sind, bevor Sie mit der Extraktion von Webdaten beginnen.

- Erstellen Sie einen Scraper mit Programmiersprachen und geben Sie dann die URL einer Website ein, von der Sie scrapen möchten. Es sendet eine HTTP-Anfrage an die URL der Webseite. Wenn die Website Ihnen den Zugriff gewährt, antwortet sie auf Ihre Anfrage, indem sie den Inhalt von Webseiten zurückgibt.

- Der Scraper inspiziert die Seite und interpretiert eine Baumstruktur des HTML. Die Baumstruktur funktioniert wie ein Navigator, der dem Scraper hilft, den Pfaden durch die Webstruktur zu folgen, um die Daten zu erhalten.

- Danach extrahiert das Web Scraping Tool die Datenfelder, die Sie zum Scrapen und Speichern benötigen. Wenn die Extraktion abgeschlossen ist, wählen Sie ein Format und exportieren Sie die Daten.

Der Prozess des Web Scrapings ist leicht zu verstehen, aber es ist definitiv nicht einfach, insbesonders für Nicht-Progammierer. Glücklicherweise gibt es dank der Entwicklung von Big Data viele kostenlose Tools zum Web Scraping. Bleiben Sie dran, es gibt einige schöne und kostenlose Scraper die ich Ihnen gerne empfehlen würde.

Für Nicht-Progammierer

Hier sind 5 beliebte Web Scraping Tools von vielen vielen nicht-technischen und -professionellen Benutzern bewertet. Wenn Sie neu beim Web Scraping sind, sollten Sie es versuchen.

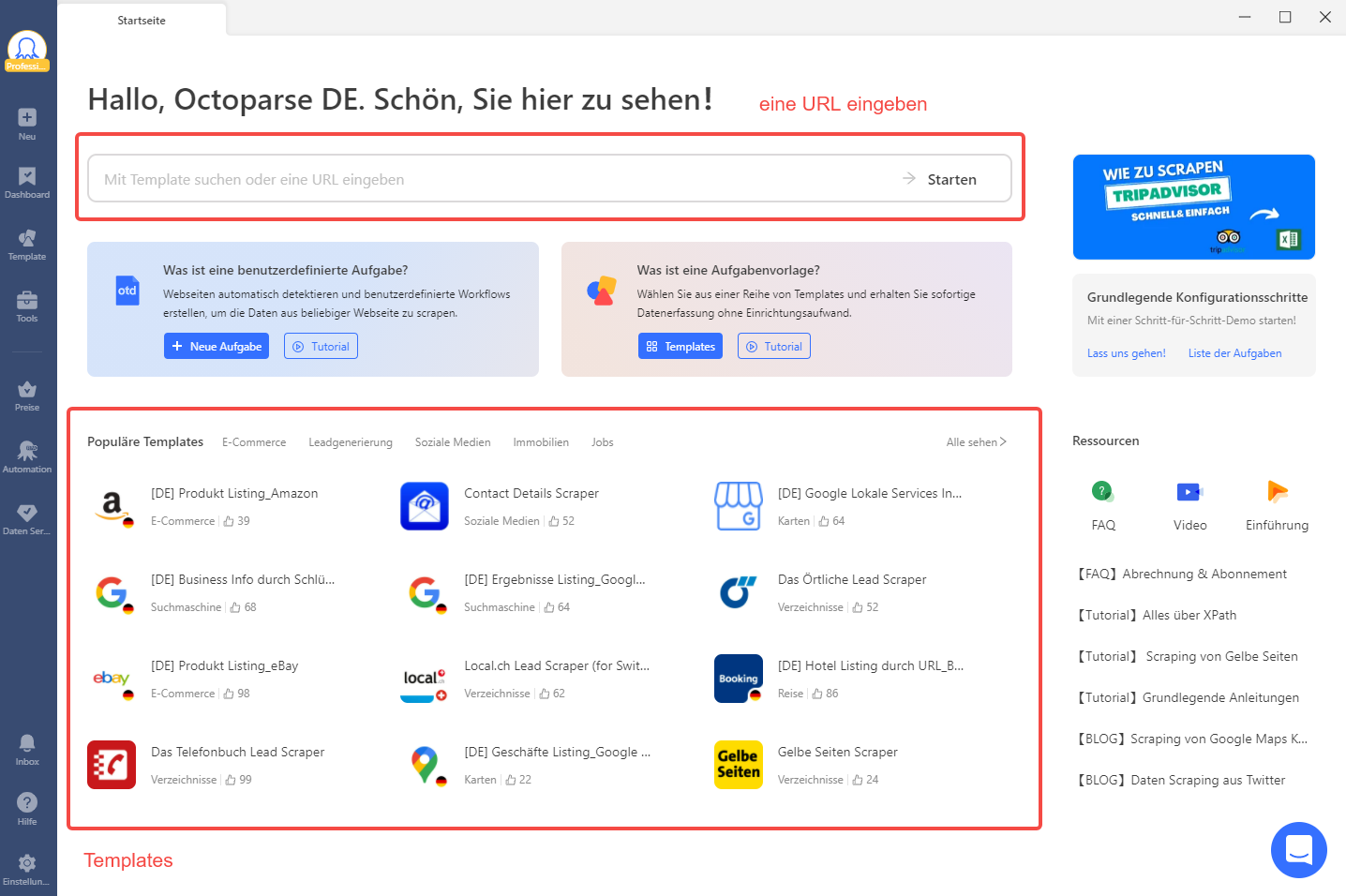

Octoparse

Octoparse ist ein leistungsstarkes Tool zur Extraktion von Webdaten. Seine benutzerfreundliche Point-and-Click-Schnittstelle kann Sie mühelos durch den gesamten Extraktionsprozess führen. Darüber hinaus machen der automatische Erkennungsprozess und die gebrauchsfertigen Vorlagen das Abkratzen für neue Starter viel einfacher.

Hier bekommen Sie Octoparse! 🤩

Preis: $0~$249 pro Monat

Packet & Preise: Octoparse Premium-Preise & Verpackung

Kostenlose Testversion: 14-tägige kostenlose Testversion

Herunterladen: Octoparse für Windows und MacOs

Cyotek WebCopy

Es ist selbstverständlich, dass WebCopy als Datenextraktionstool für Websites dient. Es ist ein kostenloses Tool zum Kopieren von vollständigen oder teilweisen Websites lokal auf Ihre Festplatte für Offline-Reichweite. WebCopy scannt die angegebene Website und lädt den Inhalt auf Ihre Festplatte herunter. Links zu Ressourcen wie Stylesheets, Bildern und anderen Seiten auf der Website werden automatisch entsprechend dem lokalen Pfad neu zugeordnet. Anhand der umfangreichen Konfiguration können Sie festlegen, welche Teile einer Website wie kopiert werden.

Getleft

Getleft ist ein Tool zur Extraktion von Website-Daten. Sie können ihm eine URL geben, es wird eine vollständige Website gemäß den vom Benutzer angegebenen Optionen heruntergeladen. Es ändert auch die ursprünglichen Seiten und alle Links zu relativen Links, so dass Sie auf Ihrer Festplatte surfen können.

OutWit Hub

OutWit Hub ist eine Web Scraping Software, die Informationen automatisch aus Online- oder lokalen Ressourcen extrahiert. Es erkennt und greift Links, Bilder, Dokumente, Kontakte, wiederkehrende Vokabeln und Phrasen, RSS-Feeds und konvertiert strukturierte und unstrukturierte Daten in formatierte Tabellen, die in Tabellen oder Datenbanken exportiert werden können.

WebHarvy

WebHarvy ist eine Point-and-Click Software für Web Scraping. Es hilft Benutzern, Daten von Websites auf ihren Computern zu extrahieren. Es sind keine Programmier/Scripting-Kenntnisse erforderlich.

Zusammenfassung

Inzwischen wissen Sie, wie leistungsfähig die Web-Datenextraktion sein kann, wie sie funktioniert und wo Sie Web-Datenextraktionstools für Nicht-Programmierer finden können. Als nächstes sollten Sie ein Tool herunterladen oder einen Crawler schreiben, um Web Scraping zu starten.

Unabhängig davon, welche Tools oder Techniken Sie verwenden werden, um Webdaten zu extrahieren, dienen sie demselben Zweck: Erhalten Sie hilfreiche Daten, um Ihr Geschäft auszubauen.

👍👍 Wenn Sie Interesse an Octoparse und Web Scraping haben, können Sie es zunächst 14 Tage lang kostenlos ausprobieren.

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Autor*in: Das Octoparse Team ❤️

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.