Mac-Nutzer stoßen oft auf das Problem, dass ein guter Web Scraper nur für Windows oder Linux verfügbar ist. Mit einem passenden Web Scraper Web können Sie jedoch auch auf MacOS problemlos Daten extrahieren.

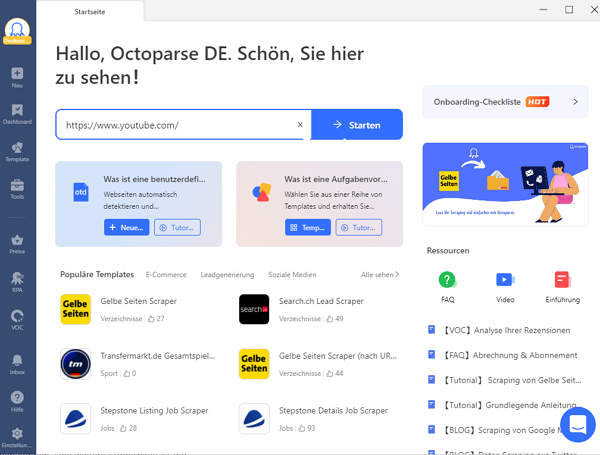

Mit Octoparse haben Sie die passende Lösung gefunden. Dieser Web Scraper Mac bietet zahlreiche Vorteile und eine sehr einfache Bedienung. In diesem Artikel lernen Sie die Web Scraping Tools etwas besser kennen.

Kostenloses Web Scraping auf Mac

Mit Octoparse, einer branchenführenden Web-Scraping-Software für Mac, ist es kein Problem mehr, Daten auf einer Website zu extrahieren. Ein Web Scraper Web überzeugt durch hohe Geschwindigkeit und starke Kompatibilität. Für Apple-Geräte ist er eine einfache und kostenlose Lösung zum Scrapen von Daten. Sie können die Octoparse Mac-Version hier herunterladen.

Was muss ein guter Web Scraper Mac können?

Mit einem guten Web Scraper für Mac können Sie Daten von jeder beliebigen Website ohne Programmieraufwand scrapen. Octoparse macht Web Scraping so einfach wie nie zuvor. Dieses Tool hat viele Vorlagen für Web Scraping. Damit lassen sich Shops wie Amazon, eBay, BestBuy oder Walmart scrapen. Auch Social-Media-Kanäle wie Facebook, Twitter, Instagram und YouTube sind möglich. Mit einem Web Scraper Web lassen sich Verzeichnisse wie Gelbe Seiten, Yelp oder Crunchbase einfach auslesen. Auch Daten von Reiseportalen wie Booking, TripAdvisor oder Airbnb können so schnell gesammelt werden. Ebenfalls können Immobilienangebote von Kijiji, Gumtree problemlos gescrapt werden.

Mit diesen fertigen Crawlern holen Sie mit wenigen Klicks Daten von Seiten wie Google Maps oder Google Search. Auch Google Play, Yahoo Finance und Indeed lassen sich damit einfach auslesen.

Scrapen Sie die Webdaten auf Ihrem Gerät

Um beliebige Websites zu scrapen, gibt es eine flexiblere Lösung – mit dem “Advanced Mode” in Octoparse können Sie einen inpiduellen Crawler nach Ihren Bedürfnissen erstellen.

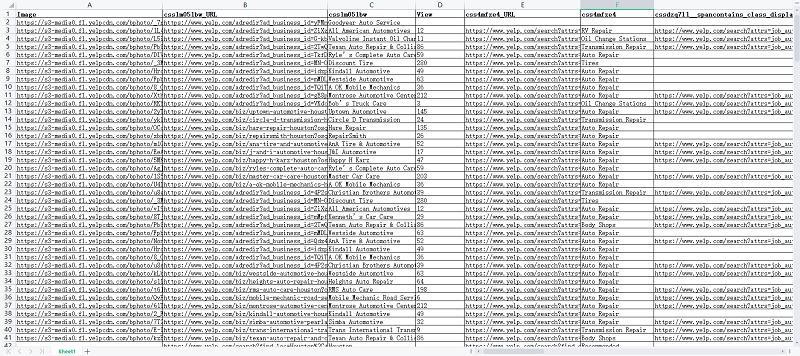

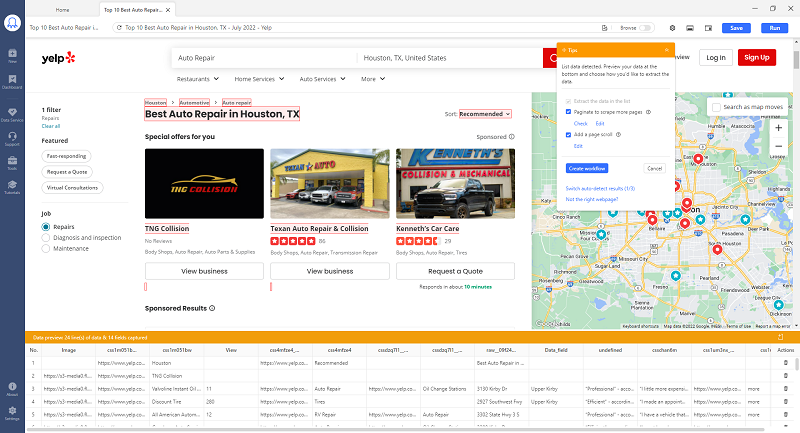

Es ist sehr einfach, einen Crawler zu erstellen, der Daten von einer Website scrapt. Selbst Laien einen Crawler innerhalb Minuten erstellen können, ohne Programmierkenntnisse zu lernen. Mit Octoparses automatischer Detektion werden alle Datenfelder auf der Webseite automatisch erkennt, und man kann sehr schnell das Konfigurieren des Crawlers erledigen und die Daten innerhalb von Sekunden erhalten. Unten sehen Sie einen Screenshot der Daten, die ich mit der automatischen Detektion gescrapt habe:

Nehmen wir Yelp als Beispiel. Nehmen wir an, dass Sie alle allgemeinen Informationen über Autowerkstätten in Houston, TX extrahieren möchten. Als Bespiel nehmen wir die URL: https://www.yelp.com/search?find_desc=Auto+Repair&find_loc=Houston%2C+TX%2C+United+States&ns=1

✅ Schritt 1: Geben Sie die Ziel-URL ein, um die Detektion der Webseite zu starten

Zuerst müssen Sie Octoparse auf Ihrem Mac-Gerät installieren. Wenn Sie bereits Erfahrung mit der Windows-Version haben, werden Sie bemerken, dass die Mac-Version sehr ähnlich aussieht.

Fügen Sie die obige URL in Octoparse ein, damit die Seite automatisch erkannt wird. Wenn Sie die Seite im eingebauten Browser nach unten scrollen, werden Sie feststellen, dass die Auflistungsdaten sowie die Schaltfläche “Next page” rot hervorgehoben sind. Das bedeutet, dass Octoparse alle hervorgehobenen Daten auf allen Seiten extrahieren wird.

✅ Schritt 2: Speichern Sie die Erkennungseinstellungen, um einen Crawler zu erstellen

Der zweite Schritt ist sehr einfach. Klicken Sie auf “save” und Octoparse wird auf der linken Seite einen Scraping-Workflow generieren. Sie können alle Daten, die extrahiert werden sollen, im Abschnitt “data preview” in der Vorschau finden. Zusätzlich können Sie den Workflow jederzeit anpassen, falls Sie bestimmte Felder ändern möchten. So haben Sie die volle Kontrolle über Ihren Web Scraper.

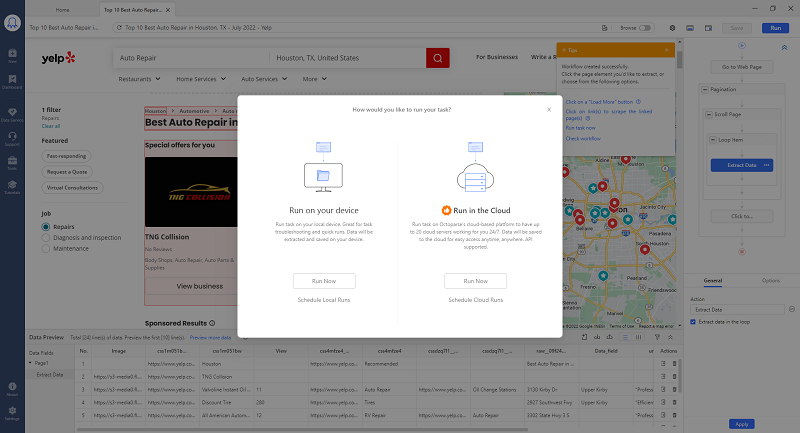

✅ Schritt 3: Führen Sie den Crawler aus

Und der letzte Schritt ist noch einfacher: Speichern Sie den Crawler und führen Sie ihn aus. Dann werden Ihre Zieldaten innerhalb von Sekunden aus der Webseite extrahiert. Wenn die Extraktion fertig ist, können Sie die Daten in verschiedene Formate exportieren. Dazu gehören zum Beispiel Excel, CSV, HTML oder Datenbanken wie MySQL. Mit Octoparse APIs können Sie auch Daten in Echtzeit in Ihre Datenbank exportieren.

Web Scraper Mac – die Octoparse-Vorlagen

Mit Octoparse stehen Ihnen über 500 benutzerfreundliche Vorlagen zur Verfügung, um Daten schnell und einfach zu extrahieren. Darüber hinaus ermöglicht Ihnen die Octoparse-Vorlage die gezielte Extraktion der gewünschten Daten auf einfache Weise. Die Benutzerfreundlichkeit der Octoparse-Vorlage ist besonders hervorzuheben! Über 30.000 Nutzer verwenden die Vorlagen.

Ein Web Scraper Web hilft Ihnen dabei, noch mehr Zeit zu sparen. Mit wenigen Klicks können Sie Daten strukturiert sammeln. So behalten Sie immer den Überblick über große Datenmengen.

https://www.octoparse.de/template/google-maps-scraper-store-details-by-keyword

FAQ – Web Scraper Mac

Was ist ein Web Scraper Mac?

Ein Web Scraper Mac ist ein Tool, mit dem Sie Daten von Webseiten automatisch sammeln können. Programmierkenntnisse sind dafür keine nötig. Alles funktioniert über eine einfache Benutzeroberfläche. Mit wenigen Klicks haben Sie die gewünschten Daten in strukturierter Form.

Kann ich mit einem Web Scraper Web jede Seite auslesen?

Ja, mit einem guten Tool können Sie fast jede Webseite scrapen. Auch Shops, Social Media oder Reiseportale sind möglich. Wichtig ist nur, dass die Seite zugänglich ist. Ein Web Scraper Web macht den Prozess schnell und leicht verständlich.

Ist ein Web Scraper Mac schwer zu bedienen?

Nein. Die Bedienung ist sehr einfach. Viele Vorlagen sind schon dabei, die Sie direkt nutzen können. Auch Anfänger kommen damit gut zurecht. Mit ein paar Klicks können Sie große Datenmengen automatisch sammeln.

Web Scraper Mac – Zusammenfassung

Das war eine kurze Demo zur Datenextraktion mit einem Web Scraper Mac. Diese Software bietet viele nützliche Funktionen. Sie können damit eine Cloud-Plattform nutzen und Projekte rund um die Uhr laufen lassen. Selbst wenn Ihr Laptop ausgeschaltet ist, bleibt der Scraper aktiv. Im Video unten sehen Sie, wie der automatische Detektion-Algorithmus funktioniert. Damit lassen sich Daten von fast jeder Website einfach scrapen.

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.