Die Datensammlung in Unternehmen dient dazu, tägliche Transaktionen und Verkehrsdaten zu analysieren und interpretieren. Mithilfe von Daten erhält man den perfekten Überblick über unterschiedliche Abläufe. Man kann den Bedarf vorhersahen und neue Programme implementieren. Aber wie genau funktioniert die Datensammlung?

Es gibt viele Methoden zur Datensammlung. In dem Artikel wird der allgemeine Prozess zur Datensammlung erläutert.

Was ist Datensammlung?

Datensammlung bezeichnet den Prozess, bei dem Daten aus verschiedenen Quellen erfasst und gespeichert werden. Dies kann entweder manuell oder automatisch geschehen. Dabei werden meist Informationen wie Namen, Adressen, Telefonnummern, E-Mail-Adressen oder demografische Daten gesammelt.

Datensammlung kann für viele Zwecke genutzt werden. Dazu gehören Marktforschung, Kundenbeziehungsmanagement, Datenanalyse, wissenschaftliche Forschung oder die Verbesserung von Dienstleistungen und Produkten. Es gibt unterschiedliche Methoden, um Daten zu sammeln. Beispiele sind Umfragen, Interviews, Beobachtungen, Webanalyse oder Datenbanken.

Bei der Datensammlung ist es wichtig, dass Datenschutz- und Ethikrichtlinien immer genau beachtet werden. Nur so werden Privatsphäre und die Rechte der betroffenen Personen geschützt.

Ist Datensammlung und Datenscraping das gleiche?

Datensammlung ist der Prozess, bei dem man Daten aus verschiedenen Quellen erfasst und speichert. Die Sammlung von Daten hilft uns dabei. Infos für verschiedene Zwecke zu nutzen. Dies kann manuell oder automatisch erfolgen. Die Daten stammen oft aus Umfragen, Interviews, Beobachtungen, Webanalyse oder Datenbanken.

Datenscraping ist dagegen ein automatisierter Prozess. Dabei werden Daten von einer Website extrahiert, indem ein Programm oder Skript die Seite durchsucht. Oft geschieht dies ohne die Zustimmung der Betreiber oder Nutzer, was in manchen Fällen illegal sein kann.

Obwohl Datensammlung und Datenscraping unterschiedliche Methoden sind, können sie ähnliche Ziele haben. Beispiele sind Marktforschung, Datenanalyse oder Kundenbeziehungsmanagement. Datenscraping sollte jedoch immer unter Beachtung von Datenschutz- und Urheberrechtsbestimmungen erfolgen.

Datensammlung – 6 einfache Schritte

Die Datensammlung kann auf verschiedene Weise erfolgen. Es kommt hier immer auf die Art der Daten an. Im Allgemeinen gibt es jedoch einige grundlegende Schritte, die bei der Datensammlung zu beachten sind:

Schritt 1: Ziele genau definieren

Bevor Sie mit der Datensammlung beginnen, sollten Sie sich klare Ziele setzen. Was möchten Sie mit den gesammelten Daten erreichen? Welche Informationen benötigen Sie genau? Überlegene Sie sich genau, welches Ziel Sie mit der Datensammlung erreichen möchten.

Schritt 2: Datenquellen wählen

Identifizieren Sie die Quellen, aus denen Sie die Daten sammeln möchten. Die Daten können aus internen Quellen wie Datenbanken oder CRM-Systemen stammen. Sie können auch aus externen Quellen wie Umfragen, Online-Plattformen oder öffentlich zugänglichen Datenbanken kommen.

Schritt 3: Entwickeln Sie eine Datenerhebungsmethode

Entscheiden Sie, wie die Datensammlung genau erfolgen sollte. Es kann sich dabei um Umfragen, Interviews, Beobachtungen, Web-Analysen oder andere Methoden handeln. Legen Sie dabei auch fest, welche Art von Fragen Sie stellen möchten. Wichtig ist auch, wie Sie die Daten erheben und speichern werden.

Schritt 4: Führen Sie die Datensammlung durch

Die Datensammlung sollte durch die zuvor gewählte Methode erledigt werden. Stellen Sie sicher, dass Sie die Datenschutzbestimmungen und ethischen Standards einhalten, um die Privatsphäre und Rechte der Betroffenen zu schützen.

Schritt 5: Daten verarbeiten und analysieren

Nach der Datensammlung sollten Sie die Daten aufbereiten und analysieren, um nützliche Informationen zu gewinnen. Nutzen Sie dazu geeignete Tools und Methoden, um die Daten auszuwerten.

Schritt 6: Ergebnisse interpretieren

Schließlich sollten Sie die Ergebnisse Ihrer Datensammlung interpretieren. So können Sie relevante Schlussfolgerungen ziehen und Handlungsempfehlungen ableiten. Die Ergebnisse sollten dabei in Bezug auf Ihre ursprünglichen Ziele und Fragestellungen betrachtet werden. Dadurch wird Ihnen eine sinnvolle Interpretation ermöglicht.

Welche Tools für Datensammlung eignen sich am besten?

Für die Datensammlung stehen mehrere unterschiedliche Tools zur Verfügung. Diese helfen den Prozess zu automatisieren. Hier sind einige Beispiele:

- Web-Crawler: Automatisierte Programme, die das Internet durchsuchen und Daten von Websites sammeln können.

- Datenbank-Management-Systeme (DBMS): Software-Tools, die die Organisation, Speicherung und Abfrage von Daten in einer Datenbank ermöglichen.

- Umfrage-Tools: Online-Plattformen wie SurveyMonkey oder Google Forms, die die Erstellung von Umfragen und die Sammlung von Antworten ermöglichen.

- Social Media Monitoring-Tools: Software, die es Unternehmen ermöglicht, Social Media-Kanäle zu überwachen und Informationen über Kundenmeinungen, Trends oder Markenbekanntheit zu sammeln.

- Datenanalyse-Tools: Software wie Excel, R oder Python, die die Verarbeitung und Analyse von Daten ermöglichen.

- Web-Analyse-Tools: Programme, die es ermöglichen, den Traffic auf einer Website zu analysieren und Informationen über Besucher und ihre Aktivitäten zu sammeln.

- Daten-Scraping-Tools: Automatisierte Programme, die Daten von Websites extrahieren, indem sie den Quellcode der Seite durchsuchen.

Tools zur Datensammlung

1. Octoparse

Octoparse ist eine Plattform zum automatisierten Extrahieren von Daten aus Websites, ohne Programmierkenntnisse erforderlich zu machen. Sie kann sowohl auf Windows- als auch auf Mac OS-Systemen verwendet werden. Unterdessen ist Octoparse eine Software besonders einfach für die Anfänger. Egal, ob Sie zum ersten Mal selbst starten, ein erfahrener Experte oder Unternehmer sind, es wird Ihre Bedürfnisse in 3 Schritten erfüllen:

- Schritt 1: Unterladen Octoparse und registrieren Sie.

- Schritt 2: Öffnen Sie die Webseite, die Sie scrapen müssen, und kopieren Sie die URL. Fügen Sie dann die URL in Octoparse ein und starten Sie das automatische Scraping. Passen Sie später das Datenfeld im Vorschaumodus oder Workflow auf der rechten Seite an.

- Schritt 3: Starten Sie das Scraping. Die extrahierten Daten können in eine Excel-Datei auf Ihr lokales Gerät heruntergeladen werden.

Im “Advanced Mode” können Sie auch Ihren eigenen Crawler erstellen. Octoparse fügt Web Scraping Templates hinzu, die über 30 Websites abdecken. So wird die Datensammlung einfacher und die Nutzung der Software vertrauter. Sie ermöglichen es Benutzern, die Daten ohne Aufgabenkonfiguration zu erfassen. Mit Octoparse können Sie die Daten innerhalb von Minuten extrahieren. Außerdem können Sie die geplante Cloud-Extraktion einrichten, die es Ihnen ermöglicht, dynamische Daten in Echtzeit zu erhalten und ein Tracking-Protokoll zu führen.

Außerdem können Sie die Octoparse-Vorlage zur Datensammlung verwenden. Die Octoparse-Vorlage ist sehr benutzerfreundlich! Über 30.000 Nutzer verwenden die Vorlagen. Probieren Sie jetzt Vorlagen kostenlos aus.

https://www.octoparse.de/template/gelbe-seiten-listing-scraper-cloud

Website zum Unterladen: https://octoparse.de/download/windows

Kundengeschichte: https://octoparse.de/CustomerStories

Mindestsystemanforderungen:

Windows 10, 8, 7, XP, Mac OS

Microsoft .NET Framework 3.5 SP1

56MB verfügbare Festplattenspeicher

2. HTTrack

HTTrack ist eine sehr einfache, aber leistungsstarke Website Scraping Freeware. Es kann die gesamte Website aus dem Internet auf Ihren PC herunterladen. Wenn Sie alle Einstellungen nach dem Assistenten fertiggemacht haben, können Sie gleichzeitig beim Herunterladen der Websites die Fotos, Dateien, HTML-Code aus der aktuellen Website abrufen lassen, ohne den Unterladen der Websites unterzubrechen.

Website: http://www.httrack.com/

Mindestsystemanforderungen:

Windows 10, 8.1, 8, 7, Vista SP2

Microsoft .NET Framework 4.6

20MB verfügbare Festplattenspeicher

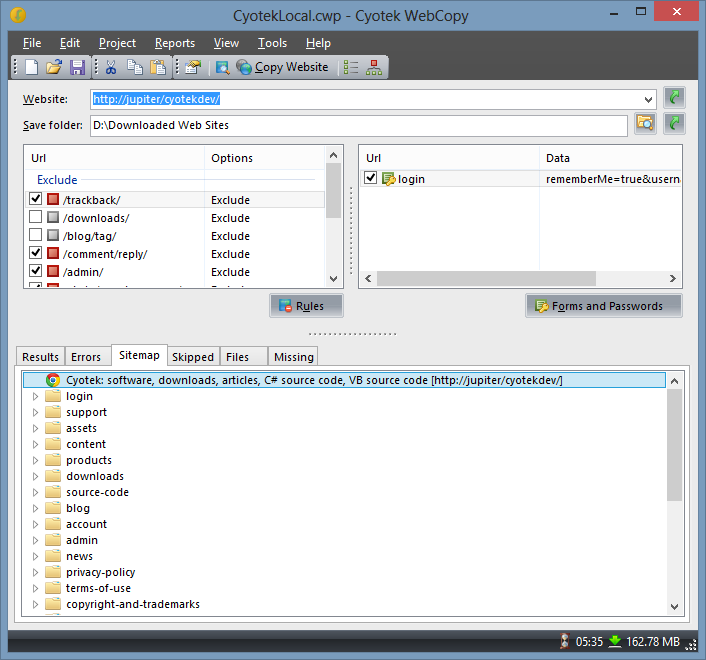

3. Cyotek WebCopy

WebCopy ist ein Website Scraper, mit dem Sie teilweise oder vollständige Websites lokal zum Offline-Lesen kopieren können. Es wird die Struktur von Websites sowie die verknüpften Ressourcen einschließlich Stylesheets, Bilder, Videos und mehr untersuchen. Auch ist eine Datensammlung möglich. Die verknüpften Ressource werden automatisch an ihren lokalen Pfad angepasst.

Website: https://www.cyotek.com/cyotek-webcopy/downloads

Mindestsystemanforderungen:

Windows, Linux, Mac OSX

Microsoft .NET Framework 4.6

3.76 MB verfügbare Festplattenspeicher

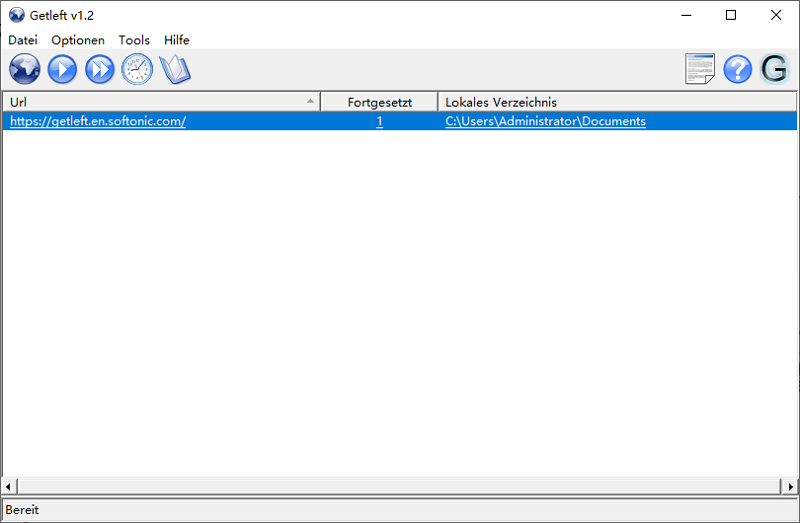

4. Getleft

Getleft ist ein kostenloser und einfach zu bedienender Website-Grabber. Er kann zum Scrapen einer Website oder Datensammlung verwendet werden. Es lädt eine ganze Website mit seiner benutzerfreundlichen Benutzeroberfläche und mehreren Optionen herunter. Nachdem Sie Getleft gestartet haben, können Sie eine URL eingeben. Danach wählen Sie die Dateien aus, die heruntergeladen werden sollen, bevor der Download beginnt.

Website:https://sourceforge.net/projects/getleftdown/

Mindestsystemanforderungen:

Windows

2.5 MB verfügbare Festplattenspeicher

FAQ – Datensammlung

1. Was bedeutet Datensammlung?

Datensammlung ist der Prozess, Daten aus verschiedenen Quellen zu erfassen und zu speichern. Dies kann manuell oder automatisch erfolgen. Das Ziel dabei ist es, die Informationen später auszuwerten.

2. Wie unterscheidet sich Datenscraping von Datensammlung?

Datenscraping ist ein automatisierter Prozess, um Daten von Webseiten zu extrahieren. Datensammlung umfasst alle Methoden der Datenerfassung, auch manuell. Scraping kann ohne Zustimmung der Webseitenbetreiber problematisch sein.

3. Welche Tools helfen bei der Datensammlung?

Es gibt verschiedene Software-Lösungen wie Octoparse, HTTrack oder Cyotek WebCopy. Diese Tools erleichtern die Datenerfassung und Automatisierung. Sie helfen dabei, große Datenmengen effizient zu sammeln und zu analysieren.

Zusammenfassung zur Datensammlung

Dieser Artikel beschreibt den Unterschied zwischen Datensammlung und Data Scraping und erläutert die sechs Schritte der Datenerfassung, einschließlich der Festlegung von Zielen, der Auswahl von Datenquellen, der Entwicklung von Datenerfassungsmethoden, der Durchführung der Datenerfassung, der Verarbeitung und Analyse von Daten und der Interpretation von Ergebnissen. Der Artikel listet auch mehrere Datenerfassungstools wie Octoparse, HTTrack, Cyotek WebCopy und Getleft auf, die den Nutzern eine Vielzahl von Lösungen für die automatische Datenextraktion bieten, und betont, wie wichtig es ist, während des Datenerfassungsprozesses den Datenschutz und ethische Normen zu beachten.

👍👍 Wenn Sie Interesse an Octoparse und Web Scraping haben, können Sie es zunächst 14 Tage lang kostenlos ausprobieren.

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Autor*in: Das Octoparse Team ❤️

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.