Web Scraping ist ein unschätzbares Werkzeug zum Sammeln großer Datenmengen von Websites. Octoparse ist eine der führenden Plattformen, die diesen Prozess vereinfacht. Ob Sie Produktdaten für eine E-Commerce-Website sammeln, Kontaktdaten aus einem Verzeichnis extrahieren oder Wettbewerber analysieren – Octoparse unterstützt Sie bei der Organisation und Automatisierung Ihres Web Scraping-Prozesses.

In diesem Artikel erfahren Sie, was eine Aufgabe in Octoparse ist und wie sie funktioniert. Am Ende verstehen Sie, wie Sie eine Aufgabe einrichten und wie sie Ihren Datenextraktionsprozess vereinfachen kann.

Was ist eine Aufgabe in Octoparse?

Eine Aufgabe in Octoparse bezieht sich auf einen bestimmten Scraping-Vorgang, den Sie im Octoparse-Tool konfigurieren. Sie stellt den gesamten Workflow dar, der den Datenextraktionsprozess definiert, einschließlich der Zielwebsite, der zu scrapenden Datenpunkte, der durchzuführenden Aktionen und der Art und Weise, wie Sie die gesammelten Daten exportieren möchten.

Eine Aufgabe in Octoparse fungiert als Hauptvorlage für das Scraping: Sie enthält Anweisungen zum Navigieren auf einer Website, zum Auffinden bestimmter Elemente (wie Text, Links oder Bilder) und zum Speichern oder Exportieren der Daten, die Sie erfassen möchten.

Aufgaben sind das Rückgrat jedes Scraping-Projekts in Octoparse und das Verständnis, wie Sie Aufgaben erstellen und verwalten, ist der Schlüssel zur erfolgreichen Automatisierung Ihrer Datenerfassung.

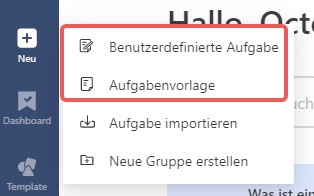

2 Möglichkeiten zum Festlegen einer Aufgabe in Octoparse

Hier sind zwei Möglichkeiten, eine Web-Scraping-Aufgabe in Octoparse zu erstellen. Sie können die Funktionen kennenlernen und die für Sie passende auswählen. Eine ausführliche Anleitung zur Octoparse – Aufgabe finden Sie auch im Hilfecenter von Octoparse.

Benutzerdefinierte Aufgabe: Erstellen Sie selbst einen Crawler (ohne Codierung)

Mit Custom Task können Sie Ihre Scraping-Aufgabe ganz nach Ihren Wünschen anpassen, z. B. durch die Suche mit Schlüsselwörtern, die Anmeldung in Ihrem Konto, das Klicken durch ein Dropdown-Menü und vieles mehr. Kurz gesagt: Custom Task ist alles, was Sie zum Scrapen von Daten von jeder Website benötigen.

Schritt-für-Schritt-Anleitung zum Erstellen einer Aufgabe in Octoparse

Schritt 1: Starten Sie eine neue Aufgabe

Öffnen Sie Octoparse und klicken Sie auf „Neue Aufgabe“. Geben Sie die URL der Website ein, die Sie scrapen möchten.

Schritt 2: Definieren Sie die Daten

Wählen Sie über die Point-and-Click-Oberfläche die Datenfelder aus, die Sie scrapen möchten. Dies können Produktnamen, Beschreibungen, Preise und mehr sein. Nach der Auswahl identifiziert Octoparse automatisch ähnliche Elemente auf der Seite.

Schritt 3: Seitennummerierung und Aktionen einrichten

Wenn sich die Daten über mehrere Seiten erstrecken (z. B. Produktlisten), richten Sie Paginierungsregeln ein , um die Daten von allen Seiten zu scrapen.

Schritt 4: Exporteinstellungen konfigurieren

Wählen Sie, wie die Daten exportiert werden sollen. Sie können zwischen CSV , Excel , JSON wählen oder die Daten direkt in der Cloud speichern.

Schritt 5: Führen Sie Ihre Aufgabe aus

Klicken Sie abschließend auf „Ausführen“ , um die Aufgabe zu starten. Sie können die Aufgabe je nach Wunsch lokal oder in der Cloud ausführen. Cloudbasierte Aufgaben laufen schneller und erfordern keinen eingeschalteten Computer.

Tipps zum Aufgabenmanagement

- Duplizieren – Aufgabe replizieren

- Löschen – Löschen einer Aufgabe

- Exportieren – Exportieren Sie die Aufgabendatei. Die Aufgabendatei kann auf Ihrem Gerät gespeichert oder zur Fehlerbehebung an das Support-Team übermittelt werden.

- Task-ID (API) – ID für die Aufgabe. Kann in API-Anfragen verwendet werden.

- Lokaler Lauf – Optionen für den lokalen Lauf: Start/Stopp oder Planen

- Cloud Run – Optionen für Cloud Run: Start/Stopp, Zeitplan oder Cloud Run-Verlauf

- In Gruppe verschieben – Verschieben Sie die Aufgabe in eine andere Gruppe.

- Daten anzeigen – Zeigen Sie die Cloud- oder lokalen Daten an

- Weitere Aktionen – Bearbeiten, Umbenennen oder Aufgabeneinstellungen

Aufgabenvorlage: Voreingestellte Daten für beliebte Websites

Task Template bietet eine große Anzahl vorgefertigter Scraping-Vorlagen für einige der beliebtesten Websites. Diese Aufgaben sind vorgefertigt, sodass Sie nur bestimmte Variablen wie den Suchbegriff und die URL der Zielseite eingeben müssen, um einen vordefinierten Datensatz von der jeweiligen Website abzurufen.

Diese Vorlagen sind sehr einfach zu verwenden. Suchen Sie einfach nach dem Stichwort, sehen Sie sich die Datenprobe in der Vorlage an und geben Sie die angeforderten Parameter ein, wenn Sie mit den Daten zufrieden sind. Ihre Daten können schnell extrahiert und exportiert werden.

Online-Vorlagen zum Scrapen von Daten ohne Download

Octoparse bietet jetzt auch Online-Vorlagen zum Daten-Scraping an, sodass Sie keine Anwendung herunterladen und auf Ihrem Gerät installieren müssen. Besuchen Sie einfach die Octoparse-Vorlagen und wählen Sie die gewünschte Vorlage aus. Alternativ können Sie den Kontaktdaten-Scraper online über den unten stehenden Link testen.

https://www.octoparse.de/template/gelbe-seiten-scraper

Zusammenfassung

Zusammenfassend lässt sich sagen, dass eine Aufgabe in Octoparse das Rückgrat Ihrer Web-Scraping-Operationen bildet. Durch die Automatisierung des gesamten Prozesses – von der Datenextraktion bis zum Export – sparen Sie wertvolle Zeit und steigern die Effizienz Ihrer Datenerfassungsprojekte. Ob Sie Produktpreise, Bewertungen oder Marktforschungsdaten scrapen – die Aufgaben in Octoparse bieten eine flexible und benutzerfreundliche Lösung, um Ihre Ziele zu erreichen.

Mit Octoparse automatisieren Sie nicht nur alltägliche Aufgaben – Sie entfesseln das volle Potenzial Ihrer Daten. Beginnen Sie noch heute mit der Erstellung Ihrer Aufgaben und überlassen Sie Octoparse die Schwerstarbeit!

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.