Möchten Sie Google-Suchergebnisse scrapen und die Daten im Excel- oder CSV-Format exportieren? Wenn Sie das Ranking Ihrer Website bei Google überwachen, Ihre Konkurrenten analysieren oder bezahlte Anzeigen bei Google analysieren möchten, ist das Scraping der Suchergebnisse der beste Weg, um damit zu beginnen.

In diesem Artikel erfahren Sie mehr überverschiedene Möglichkeiten (Codierung und keine Codierung), um Ergebnisse aus der Google-Suche zu extrahieren und sie in Excel-Dateien oder die Datenbank zu exportieren. Die Ergebnisse umfassen organische und bezahlte Ergebnisse, SERP-Suchergebnisse wie „Nutzer fragen auch“, „Ähnliche Suchanfragen“ und „Bewertungen“.

Was ist Google SERP

Google Scraping bezeichnet die automatisierte Datenextraktion aus Google-Suchergebnissen. Dadurch können umfangreiche Informationen aus den SERP-Ergebnissen (Search Engine Results Page) extrahiert werden, darunter Schlüsselwörter, Links usw. Es wird im Allgemeinen verwendet, um Website-Rankings zu analysieren, Suchtrends zu beobachten oder Daten für verschiedene Anwendungen zu extrahieren. Letztendlich ist Google Scraping ein interessanter Ansatz für Unternehmen, um erfolgreiche Strategien zu identifizieren und umfangreiche Informationen zu sammeln, insbesondere zur Verbesserung digitaler Praktiken.

Methode 1: Verwenden Sie Octoparse-Vorlagen für Google Scraping

Wenn Sie keine Ahnung vom Programmieren haben, können Sie versuchender beste Google-Such-Scraper – Octoparse. Damit können Sie die Google-Suchergebnisse ohne Codierung scrapen. Octoparse macht die Datenextraktion aus dem Web einfacher und schneller. Es extrahiert automatisch Daten von jeder Seite und speichert sie in einem übersichtlichen Format, z. B. in Excel-Dateien.

Die kostenlose Version von Octoparse deckt die meisten Ihrer Scraping-Anforderungen ab. Wenn Sie jedoch erweiterte Funktionen wie Cloud-Extraktion, zeitgesteuertes Scraping, IP-Rotation, voreingestellte Aufgabenvorlagen und weitere wünschen, können Sie eine erweiterte Version oder den Datendienst anfordern. Darüber hinaus bietet Octoparse voreingestellte Scraping-Vorlagen, mit denen Sie Daten durch Eingabe Ihrer Schlüsselwörter und mit wenigen Klicks abrufen können.

https://www.octoparse.de/template/google-search-scraper

Methode 2: Erstellen Sie einen Google Scraper ohne Codierung

Tatsächlich ist es durchaus möglich, selbst einen Google Scraper zu erstellen, auch ohne Programmierkenntnisse. Um einen Scraper ohne Programmierung zu erstellen, gibt es Tools wie Octoparse, Webscraper.io, Parsehub und verschiedene Web-Scraping-Dienste.

Die kostenlose Version von Octoparse reicht möglicherweise für die meisten einfachen Datenextraktionsaufgaben aus. Wenn Sie jedoch erweiterte Funktionen wie Cloud, Extraktionsplanung, IP-Rotation oder Tools benötigen, müssen Sie möglicherweise auf eine kostenpflichtige Version oder einen kostenpflichtigen Datendienst upgraden.

Im folgenden Abschnitt sehen wir die einfachen Schritte zum Scrapen von Google mit der kostenlosen Version von Octoparse.

Schritt 1: Öffnen Sie Google in Octoparse und geben Sie das Suchwort ein

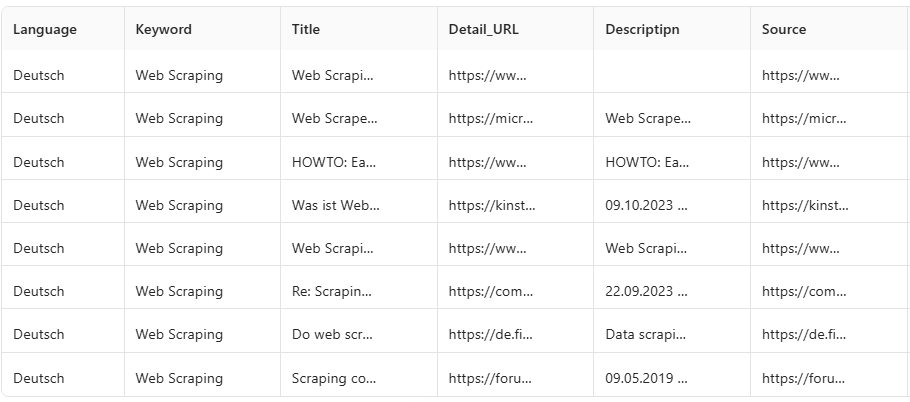

Zuerst führen Sie eine Google-Suche durch und kopieren dann die URL und fügen sie in Octoparse ein. Sie geben das Schlüsselwort „Web Scraping“ in Octoparse ein und fügen die URL anschließend in Octoparse ein. Octoparse prüft dann, ob die URL gültig ist.

Schritt 2: Klicken Sie auf die Daten auf der Detailseite

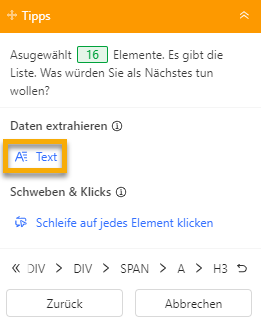

Klicken Sie auf die Elemente des ersten Ergebnisses, hier wählen wir beispielsweise die Titel aus, und klicken Sie anschließend auf „Text“, um die Daten zu extrahieren. Octoparse extrahiert die Elemente entsprechend Ihren Anforderungen, sodass Sie sie in der Datenvorschau überprüfen können.

- Text auswählen

- Wählen Sie die zu scrapenden Felder aus

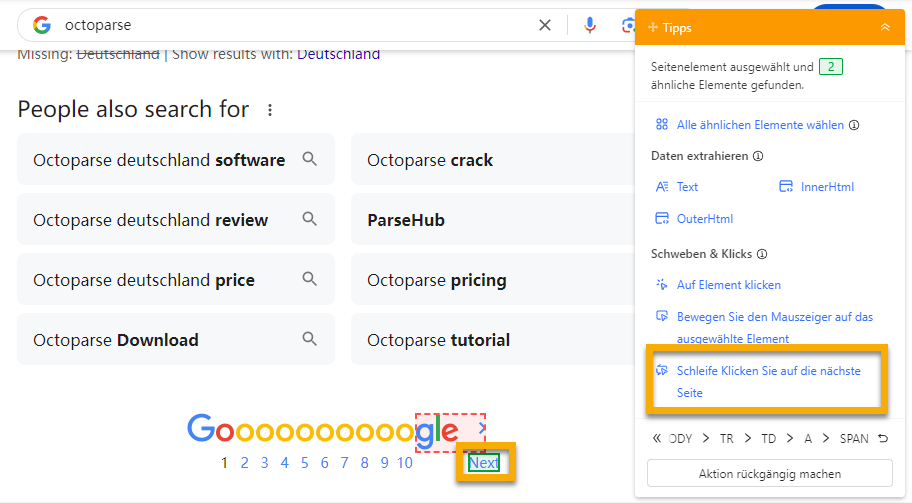

Schritt 3: Erstellen Sie eine Paginierung – Scrapen Sie von mehreren Seiten

- Klicken Sie auf die Schaltfläche „Nächste Seite“

- Wählen Sie „Schleife Klicken Sie auf die nächste Seite“, klicken Sie auf „Nächste Seite“.

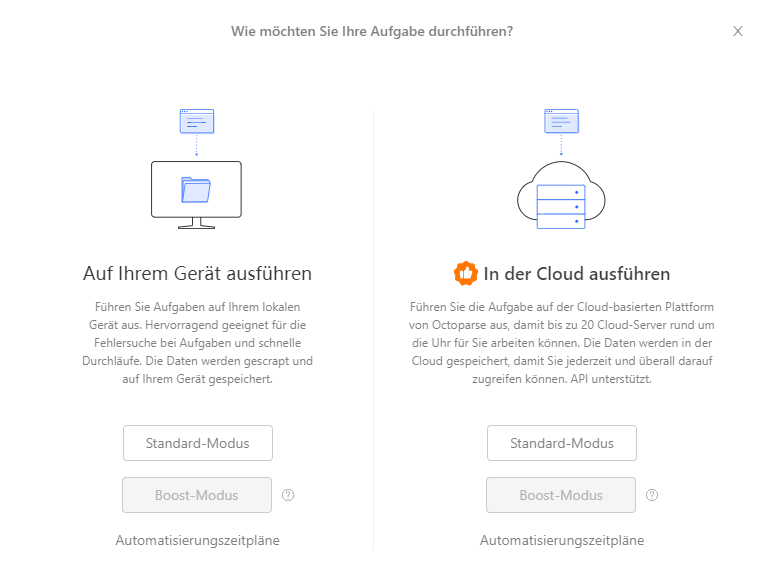

Schritt 4: Exportieren Sie die extrahierten Google-Suchergebnisse nach Excel

Klicken Sie oben auf „Starten“, um den Scraping-Vorgang zu starten. Wählen Sie aus, ob Sie den Scraper auf Ihrem Gerät oder in der Cloud ausführen möchten. Octoparse Cloud Scraping ist ein leistungsstarkes, benutzerfreundliches Tool zum Datensammeln ohne Programmierkenntnisse, das Benutzern ermöglicht, schnell und präzise Webdaten zu extrahieren und in verschiedenen Formaten für die weitere Analyse und Nutzung zu exportieren.

Sobald der Vorgang abgeschlossen ist, können Sie auf „Daten exportieren“ klicken und die extrahierten Google-Suchergebnisdaten in verschiedenen Formaten wie Excel, HTML, CSV oder JSON exportieren.

Video-Tutorial: Daten aus der Google-Suche scrapen

Methode 3: Google Scraping mit Python

Wenn Sie über Programmiererfahrung verfügen und mit dem Codieren vertraut sind, können Sie Python mit der Beautiful Soup Library verwenden, um die Suchergebnisse zu scrapen. Um diese Methode zum Scrapen von Google-Suchergebnissen zu verwenden, müssen Sie zunächst die Programmiersprache Python auf Ihrem Computer installieren. Wenn Sie Hilfe bei der Installation von Python auf Ihrem PC benötigen, können Sie sich dieses Tutorial zur Installation von Python ansehen.

Zuerst müssen wir googlesearch-python, requests, beautifulsoup4, und pandas installieren. Diese Bibliotheken helfen uns, die Suchergebnisse abzurufen, die HTML-Inhalte der Websites zu scrapen und die Ergebnisse zu speichern.

Dieses Skript führt eine grundlegende Web-Scraping-Aufgabe durch. Bei größeren Suchanfragen oder bei kommerzieller Nutzung sollten Sie die Google-Nutzungsbedingungen überprüfen und möglicherweise APIs wie die Google Custom Search API in Betracht ziehen.

Methode 4: Verwenden der API

Wie bereits erwähnt, möchten viele Nutzer Google SERP-Daten für ihre Marketingentwicklung nutzen. Wie lassen sich Google SERP-Funktionen effizienter nutzen? Ein Web-Scraping-Tool wie Octoparse kann Ihnen helfen, SERP-Daten wie Titel, Link, Beschreibung, Datum und die SERP-Position direkt zu extrahieren. Darüber hinaus sind SERP-API-Tools beliebt, da sie Proxys verarbeiten, Captchas lösen und alle Arten von strukturierten Daten aus Google-Suchen analysieren können.

Einige der beliebtesten Google SERP-APIs sind:

FAQ zum Scraping der Google-Suche

Nachdem Sie sich über den Scraping-Prozess informiert haben, finden Sie hier einige grundlegende Informationen und häufig gestellte Fragen zum Scraping der Google-Suchergebnisse, die Sie kennen sollten.

Ist das Scrapen von Google-Suchergebnissen legal?

Viele fragen sich, ob das Scrapen von Daten aus Google-Ergebnissen zulässig ist. Erlaubt Google das Scraping von Daten? Besteht eine hohe Wahrscheinlichkeit, von Google gesperrt zu werden? Zusammenfassend lässt sich sagen, dass die Rechtmäßigkeit von … komplex ist.

Scraping von Google-Suchergebnissen. Web Scraping ist nicht grundsätzlich illegal. Die Rechtmäßigkeit hängt von Faktoren wie den Nutzungsbedingungen der Website, den gescrapten Inhalten und der Gerichtsbarkeit ab.

Daher ist Vorsicht geboten. Wir empfehlen Ihnen, vor dem Scraping die Nutzungsbedingungen von Google zu lesen , die Website-Bedingungen zu beachten und bei Bedarf um Erlaubnis zu fragen. Beispielsweise wird in den Nutzungsbedingungen von Google in der Datei „robots.txt“ klar darauf hingewiesen, dass Scraping verboten ist.

Es ist auch wichtig, die Gesetze und Vorschriften Ihres Landes zu kennen. Persönliche Daten sind in den meisten Ländern gesetzlich geschützt. Ein weiterer wichtiger Aspekt ist die Datennutzung. Bitte beachten Sie, dass diese nicht für kommerzielle oder gewinnbringende Zwecke erlaubt ist. Lesen Sie auch den Artikel „Ist Web Scraping legal?“, um mehr zu dieser Frage zu erfahren.

Tipps zum Scrapen von Google, ohne blockiert zu werden

- Verwenden Sie Proxyserver

- Rotieren von IP-Adressen

- Verwenden Sie CAPTCHA-Lösungsdienste.

- Kontrollieren Sie die Schabgeschwindigkeit

- Respektieren Sie die Robots.txt-Datei von Google

- Verwenden Sie legitime APIs

- Vermeiden Sie das Scraping von Bildern

- Vermeiden Sie JavaScript

Zusammenfassung

Das Scraping von Google-Suchergebnissen kann wertvolle Erkenntnisse für Marktforschung, SEO-Analysen und Wettbewerbsanalysen liefern. Das Scraping von Google-Suchdaten bietet zwar erhebliche Vorteile, es ist jedoch wichtig, ethische Praktiken zu befolgen und die Nutzungsbedingungen von Google einzuhalten, um potenzielle rechtliche Probleme zu vermeiden.

Egal, ob Sie Octoparse für eine No-Code-Lösung oder Python/API für einen individuelleren Ansatz verwenden – es stehen Ihnen verschiedene Tools und Methoden zur Verfügung, mit denen Sie die benötigten Daten effizient extrahieren können. Mit Best Practices und den richtigen Tools können Sie Google-Suchergebnisse nahtlos erfassen und analysieren, um fundierte Geschäftsentscheidungen zu treffen.

Laden Sie Octoparse herunter und testen Sie es jetzt kostenlos, um ganz einfach mit der Extraktion von Google-Suchergebnissen zu beginnen!

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.