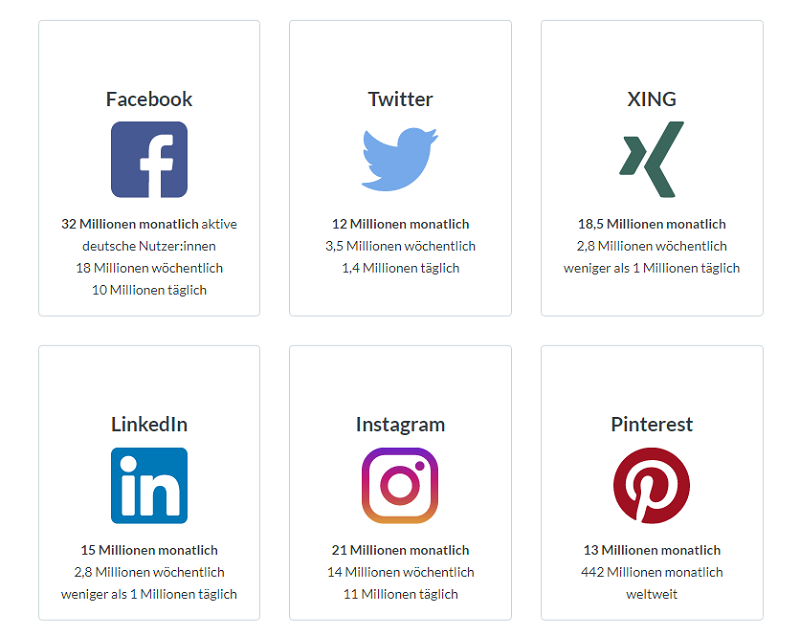

Mit Scraping-Tools kann man einfach Daten aus sozialen Medien extrahieren. Dazu gehören nicht nur soziale Netzwerke wie Twitter, Instagram, LinkedIn, sondern auch Blogs, Wikis und andere Nachrichten-Websites. Diese Plattformen teilen die Gemeinsamkeiten:

1. Die Inhalten sind von den Benutzern*innen gepostet.

2. Die Koden der Inhalten sind allen auf der Web zugänglich. Was bedeutet, jeder kann die gewünschten Infos daraus extrahieren, ohne die Regeln zu verbrechen.

Wofür scrapt man die Daten aus Social Media?

Daten, die aus sozialen Medien extrahiert werden, sind zweifellos der größte und dynamischste Datensatz über menschliches Verhalten. Sie bieten Sozialwissenschaftlern und Wirtschaftsexperten eine neue Möglichkeit, um Inpiduen, Gruppen und die Gesellschaft besser zu forschen. In der heutigen digitalen Welt eröffnen sich unzählige Möglichkeiten für die Analyse von Verhaltensmustern und Trends. Durch die Auswertung von Daten aus sozialen Medien können Forscher ein tiefgreifendes Verständnis für die sozialen, politischen und wirtschaftlichen Dynamiken unserer Gesellschaft gewinnen. Dies ermöglicht es ihnen, fundierte Entscheidungen zu treffen und zukunftsweisende Strategien zu entwickeln.

Der Artikel „Social media analytics: a survey of techniques, tools and platforms“ weist darauf hin, dass die Unternehmen aus dem Einzelhandel und der Finanzbranche zuerst die Analyse der Daten von sozialen Medien einsetzten, um die Markenbekanntheit zu steigern, den Kundenservice zu verbessern, Marketingstrategien zu entwickeln und sogar Betrug zu erkennen.

Abgesehen von den oben genannten Anwendungen können die Analyse der Daten von sozialen Medien heutzutage noch für folgende Zwecke verwenden:

✅ Messung der Kundenstimmung

Mit den gesammelten Kundenrezensionen aus sozialen Medien können Sie die Einstellung der Kunden zu einem bestimmten Thema oder Produkt analysieren, indem Sie deren Sprechweise, Kontexte und Gefühle messen. Die Analyse der Kundenstimmung ermöglicht es Ihnen, die allgemeine Kundenzufriedenheit, die Kundentreue sowie deren Absichten besser zu verstehen. Die sind wichtige Informationen für Ihre aktuellen und zukünftigen Marketingkampagnen.

✅ Zielmarkt-Segmentierung

“Ein Zielmarkt ist derjenige Teil des Gesamtmarktes für eine Ware oder Dienstleistung (ausgedrückt in Verbrauchergruppen), auf den sich eine Unternehmung (Abteilung) konzentriert”, so wird der Begriff „Zielmarkt“ definiert. Durch die Analyse von Daten aus sozialen Medien werden Sie klar sein, an wen und wann Sie Ihre Produkte oder Dienstleistungen vermarkten sollten.Die Identifizierung von gezielteren Märkten hilft Ihnen, Ihre Vermarktung effizienter zu machen.

✅ Online Brand Monitoring

Online Brand Monitoring bedeutet nicht nur, die Stimme Ihrer Kunden zu hören, sondern auch zu wissen, was Ihre Wettbewerber, die Zeitungen und sogar die KOLs (Influencer) der Branche sagen. Es geht sowohl um Ihr Produkt oder Ihre Dienstleistung, als auch um Ihren Kundenservice, den Verkaufsprozess, das soziale Engagement und jeden Touchpoint, an dem Kunden mit Ihrer Marke in Kontakt treten.

✅ Identifizierung von Markttrends

Die Identifizierung von Markttrends ist unerlässlich, damit Sie Ihre Geschäftsstrategie richtig anpassen und Ihr Unternehmen den kommenden Richtungswechseln in Ihrer Branche folgen lassen. Mithilfe Big-Data-Automatisierungstools ist die Markttrendanalyse einfach durchzuführen, indem Sie Branchendaten über einen bestimmten Zeitraum vergleichen, die Sie durch die Verfolgung der Veröffentlichungen von Branchen-Influencern und sozialen Medien erhalten können.

In diesem Artikel werden Ihnen Top 5 Scraping Tools für Social Media 2026 vorgestellt. Davon können Sie das Ihren Bedürfnissen geeigneteste wählen und verwenden. Für das Jahr 2026 gibt es eine Vielzahl von leistungsstarken Tools, die Ihnen helfen können, Daten aus sozialen Medien zu sammeln und zu analysieren. Im Folgenden werden wir Ihnen die fünf Top-Scraping-Tools vorstellen, die Ihnen dabei helfen können, die für Ihre Bedürfnisse am besten geeignete Option auszuwählen.

Top 5 Social Media Scraper

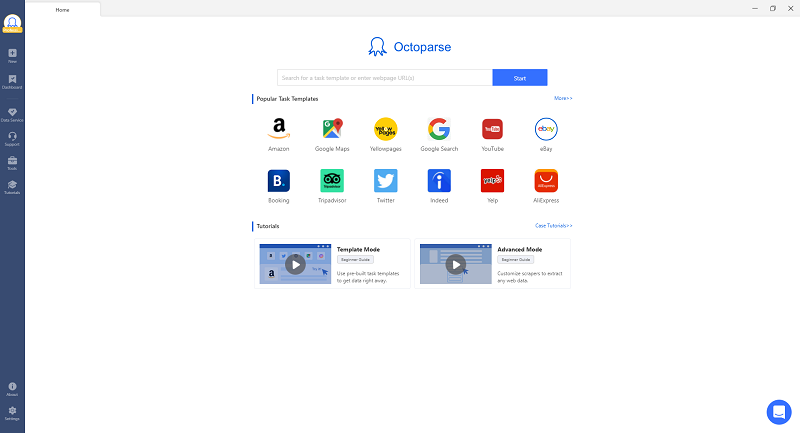

1. Octoparse ⭐⭐⭐⭐⭐

Als eines der besten kostenlosen automatischen Web-Scraping-Tools ist Octoparse für Programmierer und Nicht-Programmierer entwickelt, um komplizierte Web-Scraping-Aufgaben zu bewältigen.

Die aktuelle Version 8.5.2 hat sich viele neue Funktionen ausgerüstet.

✅ Lokale Operation

+ (Neu) Multi-Strangen “Boost Mode” für höhere Geschwindigkeit der Daten-Extraktio

+ (Neu) Lokal-Operation mit Detail

+ (Neu) Pause und Neubeginn für Lokal-Operatio

+ (Neu) Rekordieren der Lokal-Operation für alle Lokal-Aufgabe

+ (Neu) Automatische Datenspeichrung vom Lokal bis zum Cloud

✅ Konfiguration der Aufgabe

+ (Neu) Konversion der Zeitzone für Daten&Zeit Feld

+ (Neu) Hinfügen der original eingegebenen URLs in die Datenfelde (hauptsächlich für die neuedierten URLs)

+ (Neu) Mehre Alternativen für Cloud IP Mengen (in US, UK und Deuschland)

✅ Dashboard

+ (Neu) Mehre Batchbetriebsaktionen für Aufgabensmanagement (z.B duplizieren, Cloud-operation stoppen, Lokal-Operation nach Zeitplan betrieben)

+ (Neu) Mehre Sortierung- und Filterungsweisen für die Aufgaben

+ (Neu) Zeitdaten der Lokal-Operation rekordieren

+ Aufgradierte Priorität für Cloud-Operation( Umkreis von 1 bis 99)

✅ Andere

+ Die Aufgaben dürfen nach bestimmten Zeitpunktplan (z.B. um 09:10) in Betrieben gesetzt werden.

+ Die Daten dürfen nach Minutenplan (5/10/30min) automatisch expotiert werden.

+ Die Fehler-kontexten dürfen im Lokal-operationslog gezeigt werden.

Die gescrapten Daten können als Excel, JSON, HTML oder in Datenbanken exportiert werden. Wenn Sie einen Scraper erstellen möchten, um Daten von dynamischen Websites in Echtzeit zu extrahieren, eignet sich Octoparse Cloud-Extraktion (nur verfügbar für kostenpflichtigen Plan) dafür, denn Sie die Extraktion so planen können, indem die Extraktion alle 1 Minute aufgeführt werden.

Um die Benutzer zu erläutern, wie man Daten aus sozialen Medien scrapen kann, hat Octoparse viele Tutorials veröffentlicht, wie z. B. Scraping der Tweets von einem Twitter-Konto, Scraping der Job-Infos von LinkedIn und die Tutorials in Video:

Scrapen Daten aus Twitter:

Scrapen Daten aus LinkedIn:

Außerdem bietet Octoparse auch einen Datenservice, damit die Unternehmen eine kundenspezifische Datenlösung von Octoparse erhalten.

Lesen Sie die faszinierenden Kundengeschichten und und entdecken Sie, wie andere Unternehmen von Web Scraping profitieren und damit ihren Geschäftserfolg nachhaltig steigern.

Hier bekommen Sie Octoparse! 🤩

Preis: $0~$249 pro Monat

Packet & Preise: Octoparse Premium-Preise & Verpackung

Kostenlose Testversion: 14-tägige kostenlose Testversion

Herunterladen: Octoparse für Windows und MacOs

2. Dexi.io ⭐⭐⭐⭐

Das Herzstück der Digital Commerce Intelligence Suite von Dexi ist eine fortschrittliche ETL-Engine, die Ihre Lösung verwaltet und orchestriert. Die Einrichtung ermöglicht es Ihnen, die Prozesse und Regeln innerhalb der Plattform zu definieren und zu erstellen, die, basierend auf Ihren Datenanforderungen, die “Super”-Roboter anweisen, wie sie sich miteinander verbinden und andere Extraktor-Roboter steuern, um Daten aus gezielten externen Datenquellen zu erfassen.

Regeln für die Umwandlung der extrahierten Daten (z. B. das Entfernen von Duplikaten) können ebenfalls definiert werden, um die gewünschten, einheitlichen Ausgabedateien zu erstellen. Die Definition, wohin und von wo aus die Daten übertragen werden und wer Zugriffsrechte hat, wird ebenfalls innerhalb der Plattform vorgenommen; sei es Azure, Hanah, Google Drive, Amazon S3, Twitter, Google Sheets, visuelle Tools oder eine andere Umgebung.

3. OutWit Hub ⭐⭐⭐

Im Gegensatz zu Octoparse und Dexi.io bietet Outwit Hub eine einfache grafische Benutzeroberfläche sowie ausgefeilte Scraping-Funktionen und Datenstrukturerkennung. Outwit Hub begann mit einer Firefox-Erweiterung und entwickelte sich später zu einer herunterladbaren App .

OutWit Hub erfordert keine vorherigen Programmierkenntnisse. Man kann damit Links, E-Mail-Adressen, RSS-Nachrichten und Datentabellen extrahieren und die Daten in Excel-, CSV-, HTML- oder SQL-Datenbanken exportieren.

Outwit Hub verfügt über eine hervorragende “Fast Scrape”-Funktion, die schnell Daten aus einer Liste von URLs auslesen kann. Für Anfänger ist es aber notwendig, ein paar Tutorials und Dokumentationen zu lesen, denn OutWit Hub hat keine Zeigen-und-Klicken-Oberfläche und man muss sich daran gewöhnen.

4. Zyte ⭐⭐⭐

Zyte (früher Scrapinghub) ist eine Cloud-basierte Web-Crawling-Plattform, die es Ihnen ermöglicht, Ihre Crawler zu skalieren und bietet intelligenten Downloader, Web-Scraping-Dienste und Datensätze.

Die Software besteht aus 4 Tools:

+ Scrapy Cloud ist für die Bereitstellung und den Betrieb von Web-Crawlern, die auf Python basieren;

+ Portia ist eine Open-Source-Software, damit Menschen ohne Programmierkenntnisse such Daten extrahieren können;

+ Splash ist ebenfalls ein Open-Source-JavaScript-Rendering-Tool, um Daten aus Webseiten zu extrahieren, die auf JavaScript basiert;

+ Crawlera ist ein Tool, damit man vermeiden kann, von Websites blockiert zu werden, indem der Crawler von mehreren Standorten und IPs eingesetzt werden.

5. Parsehub ⭐⭐⭐

ParseHub ist ein kostenloses und leistungsstarkes Web-Scraping-Tool. Mit dem fortschrittlichen Web Scraper ist das Extrahieren von Daten so einfach wie ein Klick auf die benötigten Daten.

Es ist mit Windows, Mac OS X und Linux kompatibel und bietet eine grafische Oberfläche zum Auswählen und Extrahieren der Daten aus JavaScript- und AJAX-Seiten. Man kann mit diesem Tool Daten aus verschachtelten Kommentaren, Karten, Bildern, Kalendern und Pop-ups auslesen.

Darüber hinaus verfügt Parsehub auch über eine browserbasierte Erweiterung, um Ihre Scraping-Aufgabe schnell zu starten. Die Daten können als Excel, JSON oder über API exportiert werden.

Zusammenfassung

Außerhalb der Verwendung der automatischen Web-Scraping-Tools bieten mittlerweile viele soziale Medien auch kostenpflichtige APIs für Benutzer, Akademiker, Forscher und spezielle Organisationen an, z. B. Thomson Reuters und Bloomberg im Nachrichtendienst, Twitter in sozialen Netzwerken.

Angesichts der schnell Entwicklung der Online-Wirtschaft bieten soziale Medien viele neue Möglichkeiten für Unternehmen, sich in seinem Bereich abzuheben, indem Sie Ihren Kunden besser zuhören und mit Ihren potenziellen und aktuellen Kunden auf ganz neue Weise in Kontakt treten.

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Autor*in: Das Octoparse Team ❤️