Das Crawlen von Listen ist die häufigste Aufgabe zur Extraktion von Webdaten. Über 70% der Webdatenextraktionsaufgaben beinhalten Listen. Preisgestaltung, Wettbewerbsbeobachtung, Lead-Generierung – sie alle folgen wiederholbaren Mustern, die systematisch gecrawlt werden können.

Der schnellste Weg zum Erfolg besteht darin, listcrawl-freundliche Websites zu identifizieren, einen Satz Extraktionsregeln auf alle Elemente anzuwenden und von Anfang an Paginierung, Ratenbegrenzungen und Anti-Bot-Schutzmaßnahmen zu berücksichtigen. Dieser Leitfaden zeigt Ihnen genau, wie das geht.

Listen-Crawling vs. allgemeines Web-Crawling

Das Listen-Crawling ist fokussiert und strukturiert. Anstatt jede Seite zu besuchen, zielen Sie auf eine bestimmte Gruppe von Seiten mit gleichem Layout ab – zum Beispiel eine Produktkategorie, eine Jobbörse oder eine Bewertungsliste – und extrahieren von jedem Element die gleichen Felder (Titel, Preis, Beschreibung usw.).

Beim allgemeinen Web-Crawling geht es dagegen darum, möglichst viele Seiten zu besuchen und deren Inhalt zu indizieren – ähnlich wie Google das Internet durchsucht, um Suchergebnisse zu erstellen. Es ist breit gefächert, oberflächlich und darauf ausgelegt, Seiten zu entdecken.

Stellen Sie sich das so vor: Allgemeines Crawling = „Finde alles für mich.“

Listen-Crawling = „Sammle genau diesen Datentyp von jedem Element in dieser Liste.“

Beim Listen-Crawling geht es normalerweise auch um die Handhabung von Seitennummerierung, unendlichem Scrollen und sich wiederholenden Mustern, während beim allgemeinen Crawling nur Links gefolgt wird, ohne sich um die Datenstruktur zu kümmern.

Welche Arten von Websites eignen sich am besten für das Listen-Crawling?

Nachdem ich Tausende von Websites durchsucht habe, habe ich festgestellt, dass bestimmte Merkmale stets den Erfolg vorhersagen.

TL;DR: Wo Einträge am häufigsten angezeigt werden

| Kategorie | Beispiele | Warum sie wichtig sind |

|---|---|---|

| Soziale Medien | Instagram-Profile, LinkedIn-Mitarbeiterverzeichnisse, Twitter-Hashtags | Wettbewerbsanalyse, Influencer-Marketing, Talent Mapping |

| E-Commerce | Amazon-Produktvarianten, abgeschlossene eBay-Angebote | Preisinformationen, Marktforschung |

| Fachdaten | AngelList-Finanzierungsrunden, GitHub-Repos | Investmentrecherche, Rekrutierung |

| Lokal/Karten | Google Business-Einträge | Lokale SEO-Audits, Überwachung der Konkurrenz |

1. E-Commerce und Produktkataloge

Wenn ich Websites wie Hersteller-Produktseiten oder Marktplatzlisten besuche, suche ich nach

- Einheitliche Datenfelder für alle Elemente.

- Preis, Titel, Beschreibung und Bilder erscheinen mit minimalen Abweichungen an denselben Stellen.

- Klare Paginierungsmuster und vorhersehbare URL-Strukturen machen die systematische Extraktion unkompliziert.

Amazon-Produktseiten stellen den Goldstandard für das Listen-Crawling dar.

Jede Produktliste folgt derselben Vorlage, die Seitennummerierung funktioniert vorhersehbar und die Datenstruktur bleibt auch bei Änderungen des visuellen Designs konsistent.

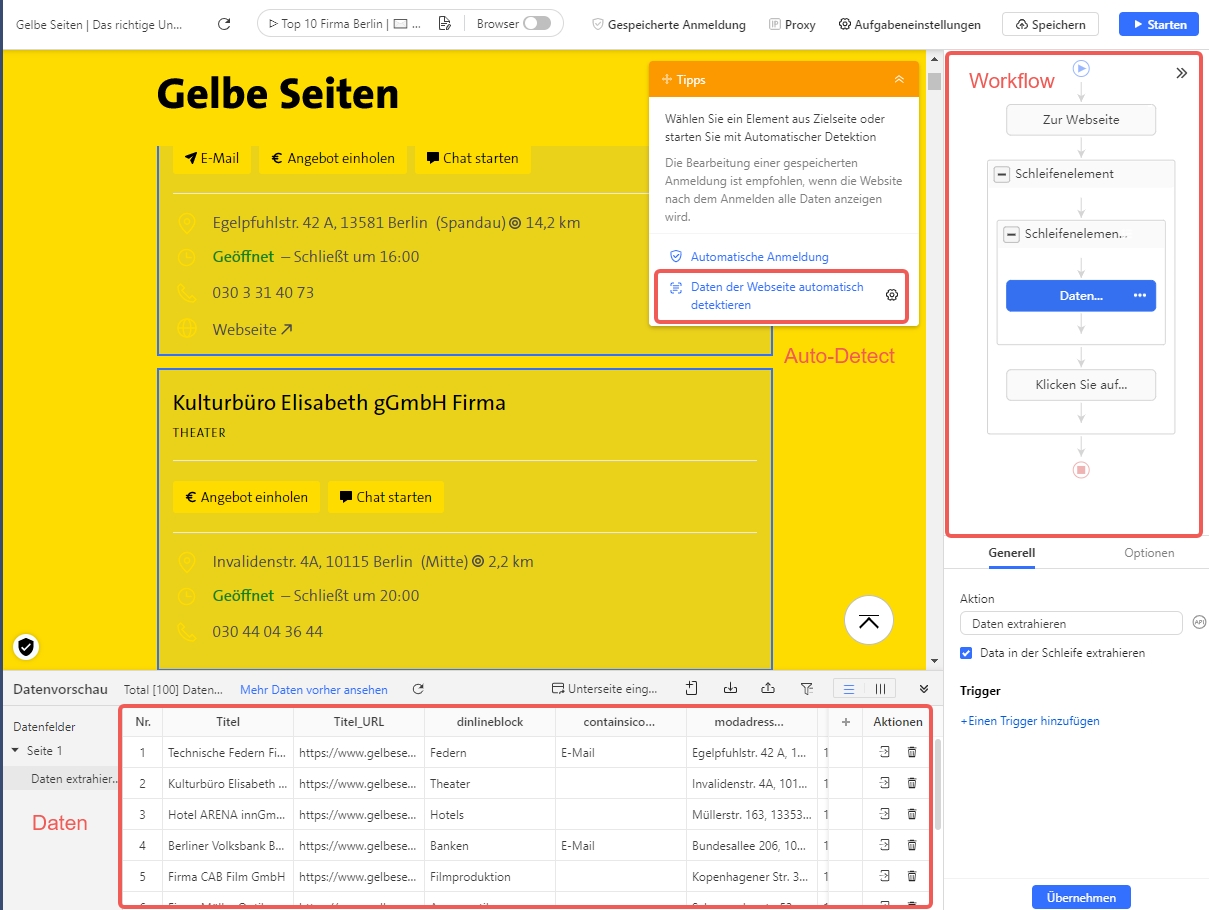

2. Branchenverzeichnisse und Dienstleistungsverzeichnisse

Websites wie Yelp oder Branchenverzeichnisse präsentieren Unternehmensinformationen in standardisierten Formaten. Kontaktdaten, Öffnungszeiten und Bewertungsdaten folgen einheitlichen Strukturen, unabhängig davon, ob Sie nach Standort oder Kategorie suchen.

Bei der Analyse von Verzeichnisseiten prüfe ich, ob die Brancheneinträge dieselben Informationsfelder enthalten und ob die Organisation logisch bleibt. Darüber hinaus sollten die geografische Filterung und die Kategoriesuche auf der gesamten Website zuverlässig funktionieren.

3. Jobbörsen und Karriereseiten

Stellenausschreibungsportale verwenden standardisierte Formate, die eine zuverlässige Extraktion ermöglichen. Gehaltsinformationen, Standortdaten, Unternehmensdetails und Veröffentlichungsdaten werden in allen Stellenausschreibungen einheitlich angezeigt.

Ich habe mit Websites wie Indeed oder den Karriereseiten von Unternehmen hervorragende Crawling-Ergebnisse erzielt, da diese darauf angewiesen sind, dass Nutzer ähnliche Positionen schnell vergleichen können. Diese Geschäftsanforderung erfordert eine konsistente Datendarstellung und ist daher ideal für das Crawling.

4. Bewertungs- und Inhaltsplattformen

Bewertungsportale präsentieren Nutzerfeedback in einheitlichen Strukturen mit konsistenten Bewertungssystemen und zeitlicher Gliederung.

Nachrichtenaggregatoren und Inhaltsplattformen verwenden standardisierte Artikelvorschauen mit Veröffentlichungsmetadaten.

Der rote Faden erfolgreicher Ziele: Sie präsentieren ähnliche Informationen mit identischem Layout. Wenn Sie dieselben Datenfelder mit minimalen Abweichungen sehen, haben Sie eine ideale List-Crawling-Site gefunden.

Wie kann man feststellen, ob die Listen einer Website gecrawlt werden können?

Bevor ich entscheide, ob ich eine Website listcrawlen kann oder nicht, führe ich eine fünfminütige Bewertung durch. Diese Bewertung hilft mir zu entscheiden, ob die Site mit mir kooperiert oder sich gegen meine Extraktionsversuche wehrt.

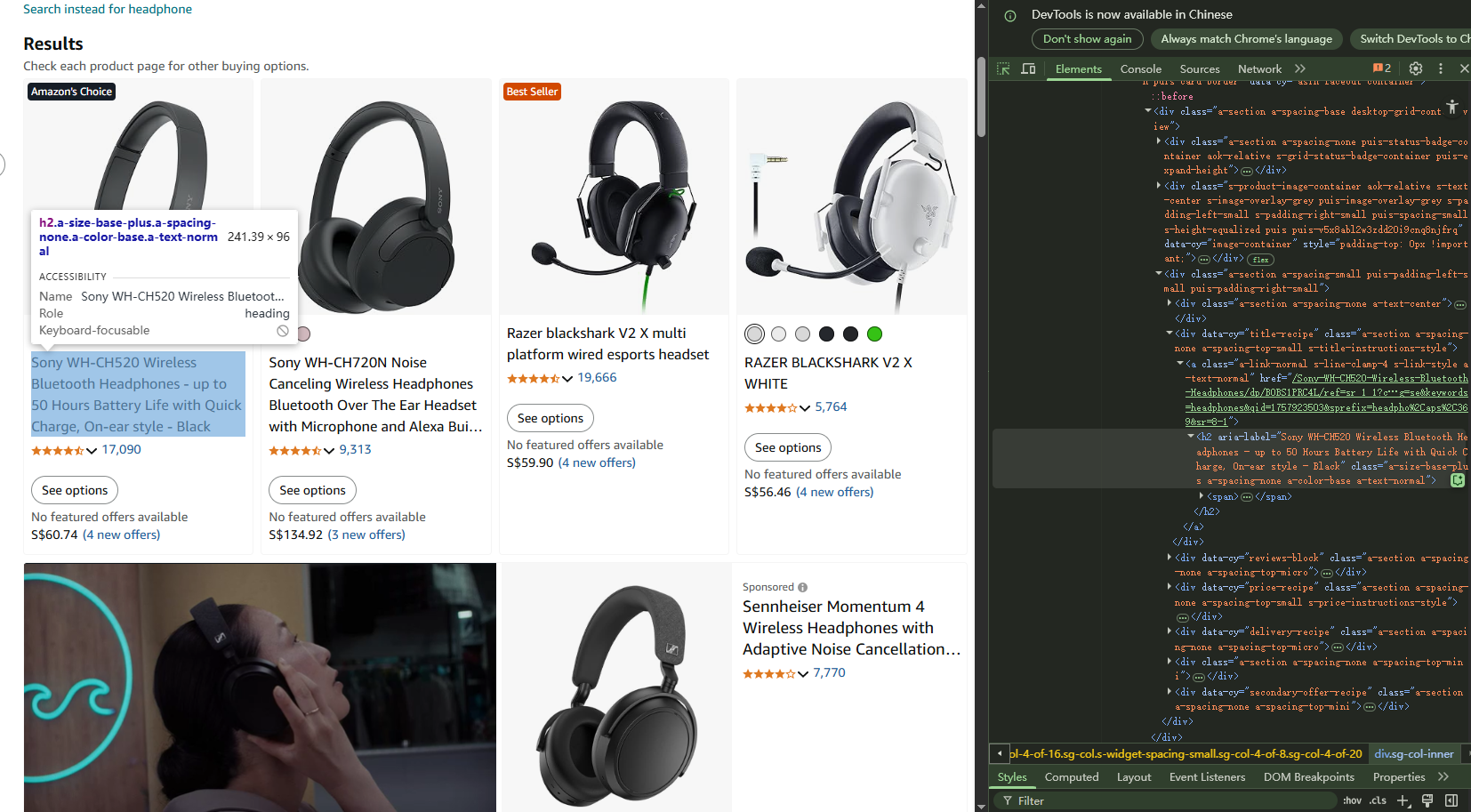

1. Überprüfen Sie den Inhalt der Seitenquelle

Um zum Inhalt der Seitenquelle zu gelangen, klicken Sie einfach mit der rechten Maustaste auf ein beliebiges Listenelement und zeigen Sie die Seitenquelle an. Suchen Sie dann nach HTML-Elementen mit Ihren Zieldaten, konsistenten Klassennamen für ähnliche Elemente und strukturiertem Markup wie JSON-LD.

Wenn Sie Ihre Zieldaten in der HTML-Quelle deutlich sehen können, sind sie crawlbar.

Hinweis: Leere Divs oder Platzhaltertext , der von JavaScript ausgefüllt wird, weisen auf dynamische Inhalte hin , die anspruchsvollere Techniken erfordern.

2. Überprüfen Sie die URL-Strukturmuster

Crawlbare Listen verwenden vorhersehbare URL-Muster für die Navigation. Ich empfehle, bei der Paginierung nach vorhersehbaren URL-Mustern zu suchen, wie zum Beispiel:

- example.com/products?page=1 logisch weiter zu page=2, oder

- kategoriebasierte Strukturen wie example.com/electronics/p2.

Warnsignale sind URLs, die sich nicht ändern oder komplexe, von JavaScript generierte Token enthalten. Einmal habe ich mehrere Tage auf einer Website verbracht, auf der alle Seiten dieselbe URL hatten, aber unterschiedliche Inhalte per JavaScript geladen wurden – die Paginierung war vollständig dynamisch.

3. Navigationsverhalten testen

Ich würde mich manuell durch drei oder vier Seiten klicken.

Seitenzahlen sollten konsistent funktionieren, die Zurück-Schaltfläche des Browsers sollte ordnungsgemäß funktionieren und Listenelemente sollten sofort und ohne Verzögerungen geladen werden.

Wenn Sie eine fehlerhafte Seitennummerierung, eine inkonsistente Navigation oder komplexe Ladesequenzen feststellen, muss die Konfiguration Ihres Webcrawlers möglicherweise angepasst werden, beispielsweise durch das Schreiben eines XPath für die Seitennummerierung.

4. Überprüfen Sie die Ratenbegrenzungsreaktion

Öffnen Sie schnell fünf oder sechs Seiten in neuen Browser-Tabs.

Seiten, die nicht geladen werden können, CAPTCHA-Herausforderungen anzeigen oder die Meldung „zu viele Anfragen“ anzeigen, weisen darauf hin, dass Ihr automatisiertes Crawling möglicherweise zu aggressiv ist.

Listen-Crawling verschiedener Arten von Websites

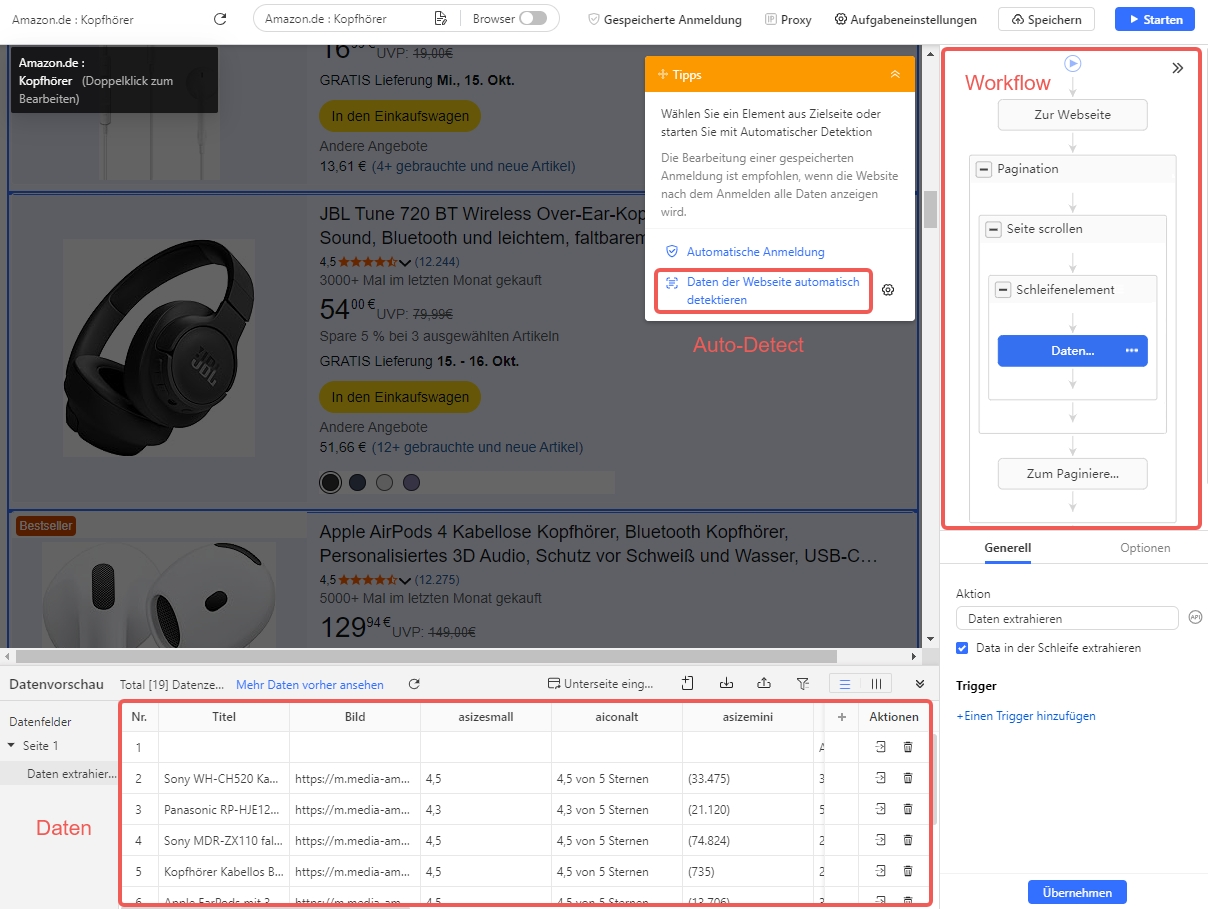

Wenn ich mich nicht mit Codierung und Debugging befassen möchte, bevorzuge ich Octoparse zum Listen-Crawlen, da es die technische Komplexität bewältigt und ich mich gleichzeitig auf das Abrufen der benötigten Daten konzentrieren kann.

Sie können es kostenlos herunterladen und es funktioniert unter Windows (Mac-Version ebenfalls verfügbar).

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.

Verschiedene Websites strukturieren Listendaten unterschiedlich. Daher passe ich meinen Ansatz immer an die Art der Liste an, mit der ich es zu tun habe. So gehe ich mit den drei gängigsten Listenstrukturen um:

1. So crawlen Sie tabellenbasierte Listen

Nachdem ich festgestellt habe, dass es sich bei den Zieldaten um eine Tabellenliste handelt, öffne ich als Erstes Octoparse. Ich klicke auf „Mit einer URL beginnen“ und füge die erste Seite der Liste ein, die ich crawlen möchte.

Die Software lädt die Seite in ihrem integrierten Browser, sodass ich genau sehen kann, womit ich arbeite.

Dann verwende ich die Funktion „Webseitendaten automatisch erkennen“, die die Seite schnell scannt und die Tabellenelemente hervorhebt, wobei Zeilen und Spalten automatisch ausgewählt werden.

Wenn die automatische Erkennung etwas übersieht, wähle ich manuell die erste Zelle der ersten Zeile aus und erweitere die Auswahl, bis die gesamte Zeile hervorgehoben ist. Octoparse findet dann für mich die anderen Zeilen mit ähnlichen Strukturen.

Anschließend überprüfe ich, ob alle gewünschten Spalten enthalten sind, benenne alle Spaltenüberschriften zur besseren Übersichtlichkeit um und entferne nicht verwendete Felder. Wenn die Tabelle mehrere Seiten umfasst, richte ich die Paginierung ein, indem ich Octoparse anweise, auf „Weiter“ zu klicken, um weitere Seiten zu crawlen.

Abschließend führe ich eine Testextraktion durch, um sicherzustellen, dass alle Zeilen und Zellen genau erfasst werden, bevor ich das vollständige Listen-Crawling ausführe und die Daten im CSV- oder Excel-Format exportiere.

Weitere Informationen Weitere Informationen zum Crawlen oder Scrapen von Tabellendaten in Octoparse finden Sie in unserem Tutorial.

2. Crawlen von Daten in Registerkarten oder Schnittstellen mit Registerkarten

Manchmal verwenden Websites Registerkarten, um Listendaten auf einer Seite zu organisieren – beispielsweise Produktvarianten, Spezifikationen oder Benutzerbewertungen in separaten Registerkartenfeldern.

Ich lade die Webseite mit Tabs und richte Aktionen ein, um nacheinander auf jeden Tab zu klicken und so sicherzustellen, dass der Inhalt für die Extraktion sichtbar wird. Anschließend verwende ich die automatische Erkennungsfunktion oder die manuelle Auswahl, um die Daten in jedem Tab zu erfassen.

Wenn mehrere Registerkarten oder verschachtelte Listen vorhanden sind, konfiguriere ich eine Schleife, sodass Octoparse dynamisch alle Registerkartenabschnitte besucht und Informationen daraus extrahiert.

Ein wichtiger Trick besteht darin, beim Wechseln der Registerkarten entsprechende Wartezeiten in den Workflow einzufügen, damit der Seiteninhalt vollständig geladen wird, insbesondere wenn die Registerkarten Daten über JavaScript oder AJAX laden.

3. Crawling von Listen- und Detailseitenstrukturen

Bei Websites, die Produkt- oder Artikellisten mit Links zu Detailseiten anzeigen, umfasst der Crawling-Prozess zwei Hauptschritte: das Scraping der Übersicht auf der Listenseite und anschließendes Klicken auf jede Detailseite, um zusätzliche Informationen zu extrahieren.

Ich beginne damit, die URL der Listing-Seite in Octoparse einzugeben und die automatische Erkennungsfunktion zu starten, um alle Artikel auf der Seite zu identifizieren. Dadurch wird ein Loop-Element erstellt, das allgemeine Daten wie Produkttitel, Preis oder Zusammenfassung extrahiert.

Als Nächstes konfiguriere ich Octoparse so, dass automatisch auf jeden Eintrag geklickt wird und ich zur Detailseite navigiere, wo ich zusätzliche Datenfelder einrichte, um genauere Details zu extrahieren – wie vollständige Beschreibungen, Spezifikationen oder Bewertungen.

Die Paginierung ist so eingerichtet, dass Octoparse Daten von mehreren Listenseiten lädt und extrahiert. Nachdem ich in einem Testlauf sichergestellt habe, dass alles reibungslos funktioniert, führe ich den vollständigen Crawl aus. Dieser Ansatz ermöglicht es mir, umfangreiche Datensätze zu erstellen, die Zusammenfassungen und detaillierte Informationen effizient kombinieren.

Weitere Informationen in diesem kurzen Tutorial erfahren Sie mehr über das Crawlen detaillierter Seitendaten .

Warum ich diesen mehrschichtigen Ansatz liebe

Die Aufschlüsselung des Prozesses nach Listentypen macht es für Anfänger einfach, während technische Leser bei Bedarf tiefer eintauchen können. Dank der visuellen Point-and-Click-Oberfläche von Octoparse sind auch komplexe Listen-Crawls möglich.

Wenn Sie mehr über diese Techniken erfahren möchten, habe ich Links zu ausführlichen Tutorials bereitgestellt, die Sie Schritt für Schritt durch die einzelnen Schritte führen.

Häufige Probleme beim Listen-Crawling und deren Behebung

1. Keine oder nur teilweise Daten extrahiert

Dies bedeutet normalerweise, dass die Seite nicht vollständig geladen wurde oder Elemente in der Auswahl fehlen. So beheben Sie das Problem:

- Erhöhen Sie das Timeout für den Schritt „Zur Webseite gehen“, um den Seiten mehr Ladezeit zu geben.

- Manchmal wird durch das Hinzufügen einer Bildlaufaktion sichergestellt, dass die gesamte Liste vor dem Extrahieren geladen wird.

- Ich füge kurze Wartezeiten zwischen den Schritten ein, insbesondere bei der Verarbeitung dynamischer Inhalte.

2. Bei der Paginierung werden Seiten übersprungen oder Daten übersehen

Eine falsch konfigurierte Paginierung führt häufig zu Datenverlust. I:

- Überprüfen Sie, ob der XPath für die Schaltfläche „Nächste Seite“ präzise und stabil ist.

- Testen Sie die Seitennummerierung manuell in Octoparse, um sicherzustellen, dass die Seiten sequenziell durchgeklickt werden.

- Manchmal hilft eine Verlängerung des AJAX-Ladetimeouts dabei, Seiten vollständig zu laden, bevor fortgefahren werden kann.

3. Doppelte Zeilen in exportierten Daten

Doppelte Daten entstehen oft durch Paginierungsfehler, z. B. wenn Octoparse zweimal auf dieselbe Seite klickt oder eine falsche Schleife durchführt. Meine Korrekturen umfassen:

- XPath-Paginierung straffen oder Schleifenmodi wechseln.

- Verlassen Sie sich bei Cloud-Läufen auf die automatische Duplikatentfernung von Octoparse.

- Hinzufügen logischer Schritte zum Erkennen und Überspringen doppelter Seiten, falls erforderlich.

4. Die Aufgabe bleibt hängen oder friert mitten im Lauf ein

Dynamische Websites oder umfangreiches JavaScript können zu Problemen führen. Sie sollten:

- Überprüfen Sie das Ereignisprotokoll und das Fehlerprotokoll, um das Problem zu lokalisieren.

- Fügen Sie längere Timeouts, Bildlaufverzögerungen oder manuelle Schrittunterbrechungen hinzu.

- Erwägen Sie, große Crawls in kleinere Abschnitte aufzuteilen.

5. Begegnung mit CAPTCHAs oder Blockaden

CAPTCHAs können das Crawlen komplett stoppen. Ich gehe damit um, indem ich:

- Verwenden Sie den CAPTCHA-Lösungsschritt von Octoparse für gängige Typen wie ReCAPTCHA.

- Implementierung einer Proxy-Rotation und unterschiedlicher Anforderungsheader, um weniger wie ein Bot zu wirken.

- Verlangsamung der Crawl-Geschwindigkeit und Hinzufügen zufälliger Verzögerungen zwischen Anfragen.

So bereinige und bereite ich meine Scraped-Daten vor

Nach dem Scraping einer Datenliste treten normalerweise Probleme auf, die Ihre Analyse später erschweren können. Beispielsweise könnten Sie Folgendes sehen:

- Doppelte Zeilen, die dasselbe Element mehr als einmal anzeigen.

- In einigen Datensätzen fehlen Informationen.

- Daten, Preise oder Kategorien in vielen verschiedenen Schreibweisen.

- Zufällige HTML-Tags oder seltsame Symbole in Textfeldern.

So bringe ich meine Daten in einen guten Zustand:

- Entfernen Sie doppelte Zeilen.

Duplikate können die Analyse verwirren und zu vielen Elementen führen. Ich verwende Tools wie „Duplikate entfernen“ in Excel oder in Pythondf.drop_duplicates()in Pandas, um sie zu bereinigen. - Fehlende Daten ergänzen oder entfernen

Wenn Preise oder Daten fehlen, versuche ich, Lücken mit Durchschnittswerten oder ähnlichen Einträgen zu füllen. Wenn zu viele Daten fehlen, lösche ich diese Zeilen ggf. - Sorgen Sie für einheitliche Formate.

Ich stelle sicher, dass alle Daten demselben Format und die Preise demselben Währungsstil entsprechen. - Saubere Textfelder.

Manchmal enthalten Beschreibungen übrig gebliebenen Webcode oder seltsame Symbole. Ich entferne HTML-Tags und zusätzliche Leerzeichen, um die Beschreibungen übersichtlich zu halten.

Tools, die ich zur Datenbereinigung verwende

- Excel oder Google Sheets: Ideal für kleine Datensätze oder schnelle Korrekturen unübersichtlicher Daten.

- Python mit Pandas-Bibliothek: Perfekt für größere Datensätze oder erweiterte Bereinigungen wie das Entfernen von Duplikaten, das Ausfüllen fehlender Werte und das Formatieren von Spalten.

- OpenRefine: Ein Tool ohne Code, das beim Bereinigen unübersichtlicher Daten hilft, indem es ähnliche Einträge gruppiert und Inkonsistenzen behebt.

Hier ist ein einfaches Python-Beispiel zum Entfernen von Duplikaten und Ausfüllen fehlender Preise:

Eine gute Datenbereinigung spart mir später Zeit, verbessert die Genauigkeit meiner Analyse und hilft mir, den Erkenntnissen aus meinen Scraped-Listen zu vertrauen.

Häufige Fragen zum List Crawling

Wie kann ich mit dynamisch geladenen Listeninhalten wie Endlos-Scrollen oder Inhalten in Registerkarten umgehen?

Viele moderne Websites verwenden JavaScript, um Listenelemente dynamisch beim Scrollen oder Klicken auf Tabs zu laden. Verwenden Sie hierfür Tools, die JavaScript ausführen können, wie den integrierten Browser von Octoparse oder Selenium. Möglicherweise müssen Sie Scroll-Aktionen oder Tab-Klicks simulieren und Wartezeiten hinzufügen, damit der Inhalt vor der Extraktion geladen werden kann.

Wie vermeide ich, dass mein Crawler beim Scraping dynamischer Listen blockiert wird?

Nutzen Sie Proxy-Rotation, verlangsamen Sie die Anfragegeschwindigkeit mit zufälligen Verzögerungen, rotieren Sie Benutzeragenten und beachten Sie die Ratenbeschränkungen der Site. Octoparse bietet IP-Proxy-Unterstützung und CAPTCHA-Lösung, um Blockierungen zu minimieren.

Kann ich Daten aus login-geschützten oder sitzungsbasierten Listen scrapen?

Wenn eine Website eine Anmeldung erfordert, um die gewünschten Daten anzuzeigen, muss Ihr Crawler den Anmeldevorgang automatisch durchführen. So mache ich das in einfachen Schritten mit Octoparse:

- Öffnen Sie die Anmeldeseite im integrierten Browser von Octoparse.

- Klicken Sie auf das Feld „Benutzername“, wählen Sie „Text eingeben“ und geben Sie Ihren Benutzernamen ein.

- Klicken Sie auf das Kennwortfeld, wählen Sie „Text eingeben“ und geben Sie Ihr Kennwort ein.

- Klicken Sie auf die Schaltfläche „Anmelden“ und wählen Sie „Klicken Sie auf die Schaltfläche, um sich anzumelden“.

- Um sicherzustellen, dass Sie sich jedes Mal erneut anmelden, löschen Sie die Cookies, bevor die Seite geladen wird (legen Sie dies unter „Gehe zu Webseite > Optionen“ fest ).

- Speichern Sie Cookies nach der Anmeldung über „Zur Webseite gehen > Optionen > Cookie von aktueller Seite verwenden“, um die Anmeldung beim nächsten Mal zu überspringen (gültig bis zum Ablauf des Cookies).

- Wenn CAPTCHA lokal angezeigt wird, geben Sie es manuell ein.

Wenn Sie eine detaillierte Anleitung zum Scrapen von Daten hinter einer Anmeldung wünschen.

4. Kann ich in Schwierigkeiten geraten, wenn ich öffentlich zugängliche Listen crawle?

Das Crawlen öffentlich verfügbarer Listenseiten (wie Produktkataloge oder Verzeichnisse) ist grundsätzlich erlaubt.

Einige Websites verbieten jedoch in ihren Nutzungsbedingungen ausdrücklich die automatisierte Datenerfassung, was zu IP-Sperren oder rechtlichen Problemen führen kann. Ich empfehle Ihnen, die Richtlinien der Website stets zu überprüfen und im Zweifelsfall um Erlaubnis zu fragen.

Weitere Informationen finden Sie in unserem Blogbeitrag „Ist Web Scraping legal?“ – hier gehen wir ausführlicher auf das Thema ein. Schauen Sie sich den Beitrag gerne an!

Abschluss

Das Crawlen von Listen ist heutzutage das Rückgrat der meisten Webdatenextraktionen. Dabei ist es entscheidend zu wissen, wie man strukturierte Daten aus mit Listen gefüllten Seiten extrahiert.

Der Trick besteht darin, zu wissen, wann eine Site crawl-freundlich ist, wie man häufigen Fallen wie fehlerhafter Seitennummerierung oder CAPTCHAs ausweicht und Tools wie Octoparse zu verwenden, um es einfach zu machen – auch wenn Sie kein Programmierer sind.

Und vergessen Sie nicht die rechtlichen Aspekte: Halten Sie sich an die Site-Richtlinien, respektieren Sie die Datenschutzgesetze der Benutzer und sammeln Sie nur Daten, die Sie verwenden dürfen.

Wenn Sie diese Prinzipien beherrschen, wird das Listen-Crawling zu einem praktischen und leistungsstarken Tool zum Sammeln der hochwertigen Daten, die Sie benötigen.

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.